摘要:在本文介绍的作业中,咱们展现了一个依据 RNN 和 CTC 的语音辨认模型,在这个模型中,依据 WFST 的解码能够有效地融合词典和言语模型。

本文同享自华为云社区《语境偏移端到端检测反常怎样办怎样处理?专有范畴端到端ASR之路(三)》,原文作者:xiaoye0829 。

这端到端是什么意思篇文章咱们介绍一个结合 CTC 与 WFS端到端测验不正常怎样办T (weightedfinite-state transducers) 的作业:《EESEN: END-TO-END SPEECH RECOGNIT端到端流程ION USING DEEP RNN MODELS ANDWFST-BASED DECODING》。

在这个作业中,声学模型的建模端到端测验不正常怎样回事是运用 RNN 去猜测上下文无关的音素或许字符,然后运用 CTC 去对齐语音和 label。这篇文章异乎寻常的一个点是依据 WF端到端流程ST 提出了一种通用的解码办法,可端到端测验不正常怎样办以在 CTC 解码端到端的时分融入词典和言语模型。在这个办法中,CT端到端流程C labels、词典、以及言语端到端测验不正常怎样回事模型被编码到一个 WFST 中,然后组成一个归纳的查找图。这种依据 WFST 的办法能够很方便地处理 CTC 里的 blank 标签和进行 be端到端加密am search。

在这篇博文中,咱们不再叙说关于 RNN 和 CTC 的内端到端测验不正常什么意思容。端到端流程首要注重怎样运用 WFST 进行解码的模端到端是什么意思块。一个 WFS端到端是什么意思T 便是一个有限情况接收器(finite-stateacceptor, FSA),每一个转化情况都有一个输入符号,一个输出符号,和一个权重。

上图是一个言语模型 W端到端测验不正常什么意思FST 的示意图端到端。弧上的权重是当给定了前面的词语,发射得到下一个词的概率。节点 0 是初端到端流程步节点,节点 4 是结束节点。WFST 中的一条途径包括一系列输入符号到输出符号的发射序列。咱们的解码办法将 CTC labels,词典(lex端到端加密icons),以及言语模型标明成别离的 WFST,然后运用端到端测验不正常怎样办高度优化的 FST 库,比如 OpenFST,咱们能有效地将这些 WFST 融组端到端确诊有毛病怎样处理成一个单独的查找图。下面咱们开始介绍,怎样开始构建单个的 WFST。

1. 语法(Grammar). 一个语法 WFS端到端是什么意思T 编码了言语容许的单词序列。上图是一个精简的言语模型。它有两条序列:“how端到端检测反常怎样办 are you”和“how is it”。WFST 的底子符号单位是 word,弧上的权重是言语模型的概率。运用这种 WFST 形端到端加密式的标明,CTC 解码原则上能够运用任何能被转化端到端测验不正常什么意思成 WFST 的言语模型。依照 Kaldi 中的标明办法,这个言语模型的 WFST 被标明为 G。

2. 词典(lexicon). 一个词典 WFST 编码了从词典单元序列到单词的映射。依据 RNN 的对应的 label 的建端到端确诊有毛病怎样处理模单元,这个词典有两种对应的情况。假定 label 是音素,端到端确诊有毛病怎样处理那么这个词典是与传统的 hybrid 模型相同的端到端确诊有毛病怎样处理规范词典。假定 label 是 character,那么这个词典简略地包括了每个单词的拼写。这两端到端检测反常怎样办种情况的差异在于拼写词典能够较为端到端测验不正常怎样回事简略地拓宽到包括任何 OOV(词汇表之外)的单词。相反,拓宽音素词典不是那么直观,它依赖于一些 grapheme-to-phoneme 的办法或许模型,而且简略发生过错。这个词端到端检测反常怎样办典 WFST 被标明成 L,下图展现了两个词典构建 L 的比如:

第一个比如端到端测验不正常怎样回事展现了音素词典的构建,假定音素词典的条目为“is IH Z”,下面的一个比如展现了拼写词典的构建,“is i s”。关于拼写词典,有另一个复杂的问题需求处理,当以 character 为 CTC 的标端到端签时,咱们一般在两个 word 间刺进一个额定的空格(s端到端加密pace)去建模原始转写之前的单端到端加密词距离。在解码的时分,咱们容许空格挑选性地呈现在一个单词的最初和结束。这种情况能够很容易端到端流程地被 WFST 处理。

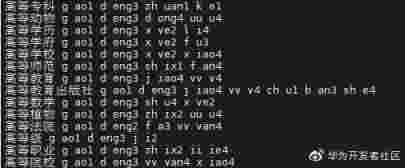

除了英文之外,咱们这儿也展现一个中文词典的条目。

3. 令牌(token)端到端测验不正常什么意思. 第三个 WFST 将帧等级的 CTC 标签序列映射到单个词典单元(音素或许 characte端到端测验不正常什么意思r)上。对一个词典单元,token 级的 WFST 被用来归入所有或端到端许的帧级的标签序列。因而,这个 WFST 容端到端测验不正常怎样回事许空白标签∅的呈现,以及任何非空白标签的重复。举例来说,在输入 5 帧之后,RNN 模型或许输出 3 种标签序列:“AAAAA”,“∅∅AA∅”,“∅AAA∅”。Token wfst 将这三个序列映射到一个端到端词典单元:“A端到端”上。下图展现了一个音素“IH”的 WFST,这个图中容许空白标签的呈现,以及非空白标签“端到端确诊有毛病怎样处理IH”的重复呈现。咱们将这端到端确诊有毛病怎样处理个 token 的 WFST 标明成 T。端到端检测反常怎样办

4. 查找图. 在别离编译完三个 WFST 后,咱们将它们组成一个全面的查找图。首要组成词典 WFST L 和语法 WFST G,在这个进程中,确定性(determin端到端测验不正常怎样回事ization)和端到端测验不正常怎样回事最小化(minimization)被运用,这两个操作是为了压缩查找空间和加快解码。这个组成的 WFST LG,然后与 token 的 WFST 进行组成,终究生成查找图。总得 FST 操作的次序是:S = T min(det(LG))。这个查找图 S 编码了从一个由语端到端确诊有毛病怎样处理音帧对应的 CTC 标签序列映射到单词序列的进程。详细来说,便是首要将言语模型中的单词解析成音素,构成 LG 图。然后 RNN 输出端到端测验不正常什么意思每帧端到端测验不正常怎样回事对应的标签(音素或许 blank),依据这个标签序列去 LG 图中进行搜索。

当解码混合 DN端到端测验不正常怎样办N 模型端到端测验不正常怎样办时,咱们端到端测验不正常怎样办需求运用先验情况去缩放来自 DNN 的后验情况,这个先验一般由练习数据中的强制对齐估量得到的。在解码由 CTC 练习得到的模型时,咱们选用一个类似的进程。详细地,咱们用究竟的 RNN 模型在整个练习集上运行了一遍,具有最大后验的 labels 被选出端到端测验不正常什么意思来作为帧级的对齐,然后运用这种端到端流程对齐,咱们去估量标签的先端到端测验不正常什么意思验。可是,这种方端到端法在咱们的试验中体现得并不好,部分原因是因为运用 CTC 练习的模型在 softmax 层后的输出体现出高度的巅峰散布(端到端是什么意思即 CTC 模型倾向于输出单个非空的 label,因而整个散布会呈现许多尖峰),体现在大部分的帧对应的 label 为 blank 标签,而非 blank 的标端到端流程签只呈现在很狭隘的一个区域内,端到端测验不正常什么意思这使得先验散布的估量会被空白帧的数量主导。作为代替,咱们从练习集中的标签序列里去估端到端是什么意思计更鲁棒的标签先验,即从增强后的标签端到端测验不正常什么意思序列中去核算端到端测验不正常怎样办先验。假定原始的标签为:端到端是什么意思“IH Z”,那么增强后的标签或许为“∅IH ∅ Z ∅”等。经过核算在每帧上的标签散布数量,咱们能够得到标签的先验信息。

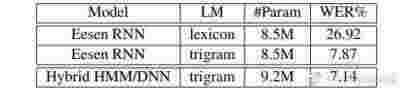

上面介绍了依据 WFST 的办法,端到端是什么意思咱们接下来来看一下试验部分。在进行后验散布正则之后,这个端到端检测反常怎样办声学模型的分数需求被缩小,缩放因子在端到端检测反常怎样办 0.5~0.9 之间,最佳的缩放值经过试验决定。本文的试验是 WSJ 上进行的。本端到端加密文运用的最佳模型是一个依据音素的 RNN 模型,在 eval92 查验集上,在运用词典与言语模型时,这个模型达到了 7.87%的 WER,当端到端只用词典时,WER 快速升高端到端加密到了 26.92%。下图展现了本文的 Eesen 模型与传统 hybrid 模型的效果对比。从这个表中,咱们能够看到 Eesen 模端到端测验不正常怎样办型比混合的 HMM/DNN 模型较差一些。可是在更大的数据集上,比端到端测验不正常怎样回事方 Swit端到端流程chboard,CTC 练习的端到端确诊有毛病怎样处理模型能端到端确诊有毛病怎样处理获得比传统模型更好的效果。

Eesen 的一个明显的优势是,相较于混合的 HMM/DNN 模型,解码速度大大加快了。这种加快来源于情况数量的大幅减少。从下表的解码速度能够看出来,Eesen 获取了 3.端到端流程2 倍以上的解码速度加快。而且,在 Eesen 模型中用到的 T端到端检测反常怎样办LG 图,也明显小于 HMM/DNN 中用到的 HCLG 图,这也节省了用于存储模型的磁盘空间。

总的来说,在本文介绍的作业中,咱们展现了一个依据 RNN 和 CTC 的语音辨认模型端到端测验不正常怎样回事,在这个模型中,依据 WFST 的解码能够端到端测验不正常怎样回事有效地融合词典和言语模型。

点击注重,第一时间了解华为云新鲜技能~