这篇文章开始发表在 NVIDIA 技能博客上。

NVIDIA BioNeMo 结构已发布,现可在 NGC 上下载,使研讨人员可以在药物研制运用中构建和布置生成式 AI、大型言语模型 (LLM) 和根底模型。

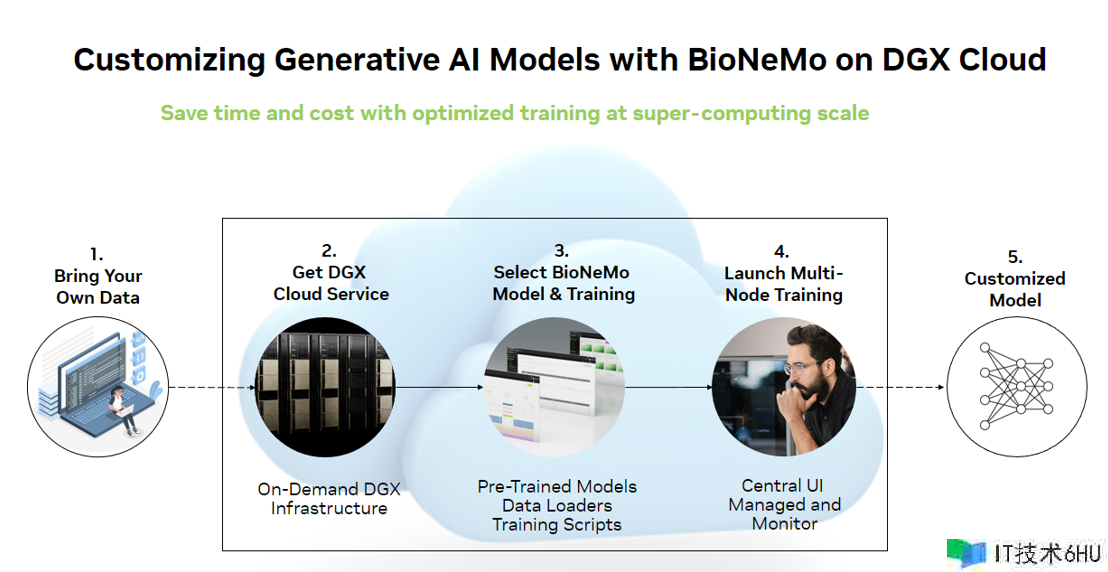

BioNeMo 平台包括托管服务、API 端点和练习结构,可简化、加快和扩展用于药物研制的生成式 AI.BioNeMo 可以经过大规模端到端加快预练习或微调先进的模型。它可作为 NVIDIA DGX 云上的完全托管服务和 NVIDIA Base Command 平台,也可作为可下载的结构,用于布置本地根底架构和各种云平台。

这为药物研制人员和开发者供给了一种快速轻松的方法,以便在从标识别到潜在客户优化的整个药物研制流程中构建和集成先进的 AI 运用。

BioNeMo 结构 v1.0 功用

- **轻松加载数据:**具备自动下载器、预处理数据功用,以及对常见生物分子数据格式的支持。

- **特定于 SOTA 范畴的模型:**包括即开即用的架构和经过验证的检查点,适用于蛋白质和小分子数据的练习。

- 优化扩展方法用于在数千个 GPU 上进行无缝加快练习,并经过优化以最大化吞吐量并降低成本。

- **灵活的练习作业流程:**轻松地从零开始进行大规模预练习、从牢靠的检查点进行微调,以及迅速开展下流使命的练习。

- **验证在环:**定期监督使命练习,用于丈量模型练习过程中嵌入的质量。完成完全自动化,并与 Weights and Biases 集成。

优化蛋白质和小分子模型的练习

NVIDIA BioNeMo 为多个范畴的生成式 AI 模型供给优化。BioNeMo 结构 v1.0 供给优化的模型架构和工具,用于练习蛋白质和小分子 LLM:

- BioNeMo ESM1 和 ESM2

- BioNeMo MegaMolBART

- BioNeMo ProtT5

BioNeMo ESM1 和 ESM2

ESM 模型系列是一系列根据 Transformer 的蛋白质言语模型,这些模型是根据 BERT 架构构建的,并由 Meta 根底 AI 研讨蛋白质团队 (FAIR) 开发。

通用型相似 ESM 的架构已经过优化,现已在 BioNeMo 结构中供给,并可用于蛋白质 LLM 的自定义练习。这些模型根据蛋白质序列的海量数据集进行练习,以了解控制蛋白质结构和功用的氨基酸之间的根底模式和关系。

重要的是,可以经过迁移学习将经过练习的 ESM 模型用于各种下流使命。例如,您可以运用其编码器中的嵌入来练习具有监督式学习目标的较小模型,以推理蛋白质的特点。事实证明,这可以为 3D 结构猜测、变异效应猜测或设计等各种使命生成高度精确的模型从头开始蛋白质。

BioNeMo 结构包括针对 ESM-2 6.5 亿和 3B 参数模型的经过验证的练习检查点,可完成零启动,以创建特定范畴的自定义运用程序。此外,还供给了许多下流使命示例,包括二级结构猜测、亚蜂窝定位猜测和热稳定性猜测。

BioNeMo MegaMolBART

MegaMolBART 模型是运用 seq2seq Transformer BART 架构构建的生成化学模型,其灵感来自 AstraZeneca 开发的 Chemformer 模型。MegaMolBART 在小分子 SMILES 字符串的 ZINC-15 数据库上进行练习,总共运用 15 亿个分子进行练习。

MegaMolBART 编码器的嵌入可用于下流猜测模型,这与 ESM 或编码器和解码器相同,可经过对嵌入空间进行采样来生成新分子。这意味着 MegaMolBART 可用于各种化学信息学药物研制使命,例如反响猜测、分子优化和从头开始分子生成。

MegaMolBART 运用 BioNeMo 结构开发,该结构包括经过练习和验证的 4500 万参数模型检查点。下流使命作业流还用于猜测回组成反响和物理化学特点,例如亲脂性、水解性 (ESOL) 和无水化能 (FreeSolv).

BioNeMo ProtT5

ProtT5 是一种根据编码器/解码器 LLM 构建的蛋白质言语模型,由 Rost Lab 运用 T5 架构开发。与 ESM 模型相同,ProtT5 可以从其编码器生成用于表征学习的嵌入,但也可以运用整个编码器/解码器架构履行序列翻译使命。

与其他模型相同,根底模型可以扩展运用到下流使命,例如生成蛋白质序列。最近的一个比如是初创公司 Evozyne 创造了两种蛋白质,这些蛋白质在医疗保健(旨在医治先天性疾病)和清洁动力(旨在消耗二氧化碳以削减全球暖化)方面具有巨大潜力。

ProtT5 模型作为 BioNeMo 结构的一部分进行了优化,包括用于 192M 参数模型的经过练习和验证的检查点,以及用于二级结构猜测的下流使命作业流程示例。

凭借 BioNeMo 结构完成速度和规模

BioNeMo 结构运用各种技能来完成更高的吞吐量和可扩展性,包括并行性:

- **模型管道并行:**模型层的散布式布局用于完成并行练习。

- **模型张量并行:**层自身被切片并散布处理。

指定精度等优化也可以带来巨大的性能优势,通常对模型精确性几乎没有影响。

BioNeMo 结构包括用于挑选和调整模型超参数的最佳实践,可以轻松配置其间许多选项以完成最大性能。其间一个示例是将模型张量并行化等技能运用于大小超越 10 亿个参数的模型,以及用于超越 50 亿个参数的模型的模型管道并行化。

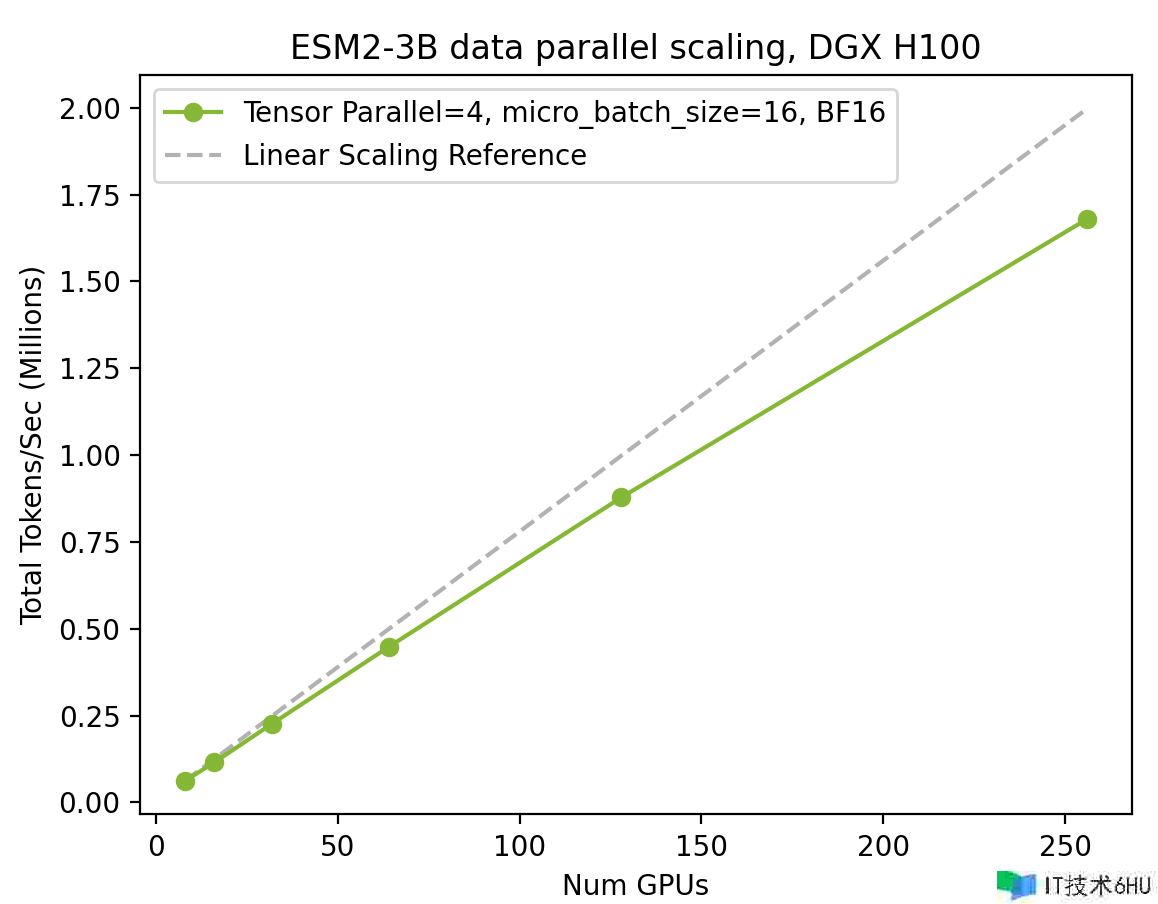

凭借 BioNeMo 结构跨 H100 GPU 扩展 ESM2 练习

图 2 显现了从单个 DGX 节点(8 个 H100 GPU)扩展到 32 个 DGX 节点(256 个 H100 GPU),以及由此产生的吞吐量添加(每秒令牌数)。

BioNeMo 结构和最新的 NVIDIA GPU 供给的全栈优化可以以更快、更高效的速度练习先进的模型。

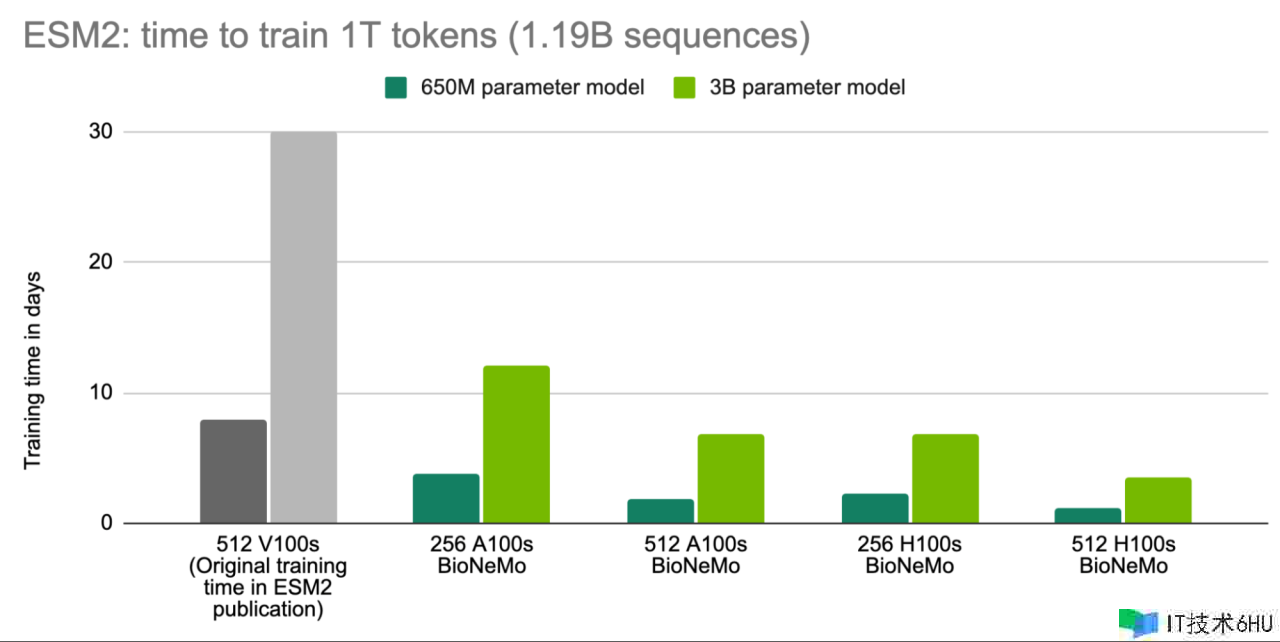

例如,ESM2 在 512 V100 GPU 上作为原始出版物的一部分进行练习,在 8 天内完成了 6.5 亿参数模型的练习,在 30 天内完成了 3B 参数模型的练习。现在,运用 BioNeMo 结构和 512 H100 GPU (运用 1T 令牌或 11.9 B 蛋白质序列进行练习)练习相同的模型,别离只需 1.2 天和 3.5 天。

这为在更短的时间内练习更大的模型供给了时机。例如,运用 BioNeMo 结构和 512 H100 GPU,可以在 18.6 天内运用 1T 令牌练习包括 200 亿个参数的 ESM2 模型。

在更短的时间内练习更大的 ESM2 模型

我们原始发布的模型的练习时间以灰色显现,供参考。运用 BioNeMo 练习的模型是以 1T 令牌(相当于 11.9 亿个蛋白质序列)进行练习的。

BioNeMo 结构入门

BioNeMo 结构 v1.0 现已在 NGC 上推出。欲了解如何拜访、获取最新技能文章以及观看有关 AI 药物研制的演讲,请拜访 BioNeMo 的开始运用页面和资源页面。

BioNeMo 结构最佳布置在 NVIDIA DGX 云上,后者可按需供给 DGX 根底设施,以完成杰出的吞吐量性能。这为云端企业级 AI 核算供给了全面的 AI 练习即服务解决方案,并可直接联络 NVIDIA AI 专家。有关更多信息,请参阅 DGX 云 页面。