咱们好,我是对白。

多使命模型中各个使命难以调参、收敛、作用平平,是一件令人头疼的事情。有没有什么能够令人省心省力的“自适应”办法呢?笔者浏览了一些最近的顶会文章,读了一些相关文章,今日挑选一篇同享给咱们~

说到多使命学习,想必咱们都不陌生。在抱负的引荐场景中,通过与辅佐使命的联合学习,能算法导论够提高方针使命的猜测作用。例如,在社交引荐中,用户偏好github永久回家地址的学习能够与辅佐使命(猜测用户之间的联系与信任)联合练习。

但抱负归抱负,现实却往往“事端多发”。说不定,在加了多个辅佐使命,并阅历艰难的调参之后,方针使命的作用却令人头秃。直觉剖析原因,有两种或许:

-

当辅佐使命发生了比方针阿里巴巴1688货源批发官网使命更大的影响,甚至分配了网梯度络权重时,方针使命的成果会变得更差;

-

另一个极点阿里巴巴股票,当一个或多个辅佐使命的影响github永久回家地址太弱时,则无法帮助方针使命提高作用。

更具或许性的状况是,上述两个或许原因在练习的过程中替换出现,而且在同一个网络的不同部分之间变化。

在多使命学习中,模型的练习loss通常由多个损失函数加权得梯度公式到,而不同使命重要程度往往是需要人为设参的,使得咱们或许在调参问题上时刻花费较多。

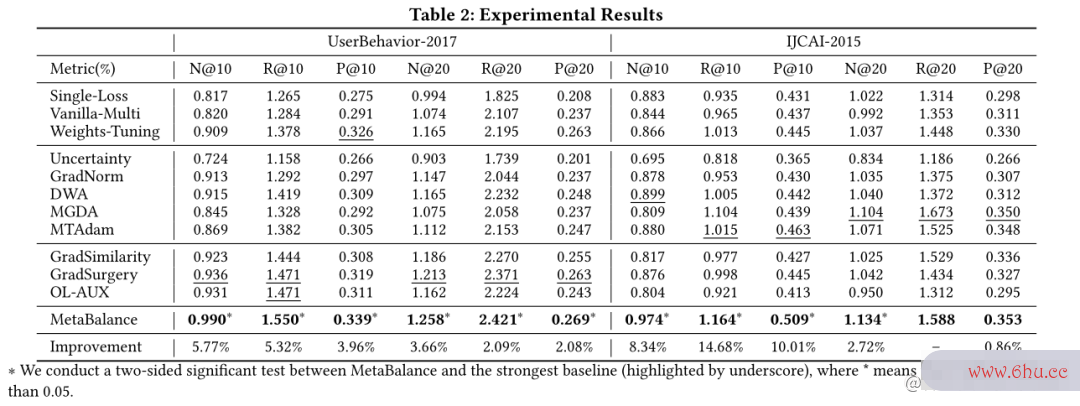

这篇文章所提的办法MetaBalance选用对辅佐使命动态梯度调算法整的办法,替代对不同使命的权重调整,在NDCG@10上针对两数据集取得了8.34%的改善。

论文标题:MetaBalance: Improving Multi-Task Re算法导论commendations via Adapting Gradient Magnitudes阿里云 of Auxiliary Tasks

论文链接:doi.org/10.1145/348…

论文代码梯度是什么意思:github.com/facebookres…

一、MetaBalance中心思维

本文由Meta AI发表于WWW2022上。在看文章具体内容之前,咱们先回想一下多使命学习github中文社区的损失函数以及梯度更新规矩:

从梯度的视点再去梯度是什么意思解释一下辅佐使命对方针使命发生负面影响的原因:

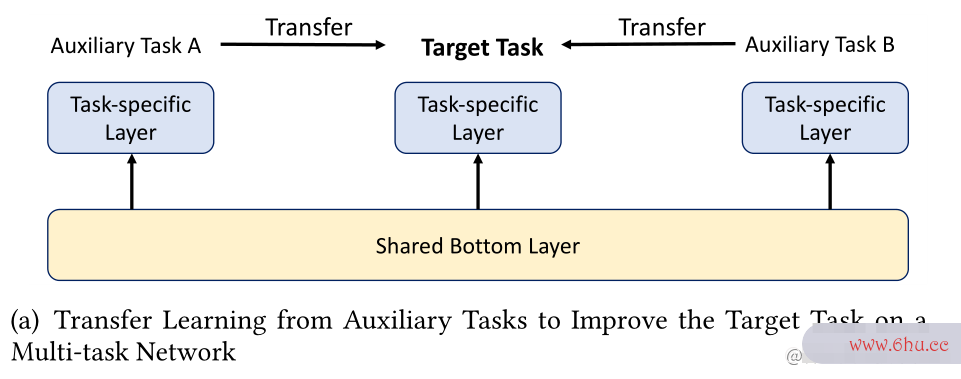

多使命网络通常由具有同享参数的bo阿里供应链ttom layer和几个ask-specific layers组成,如下图:

在练习梯度是什么意思中,每个使命都有相应的loss,并相对于多使命网络的同享参数github官网登陆入口具有相应的梯度。这些梯度的综合会影响参数的更新办法,而且梯度越大,对同享参数的影响越大。

-

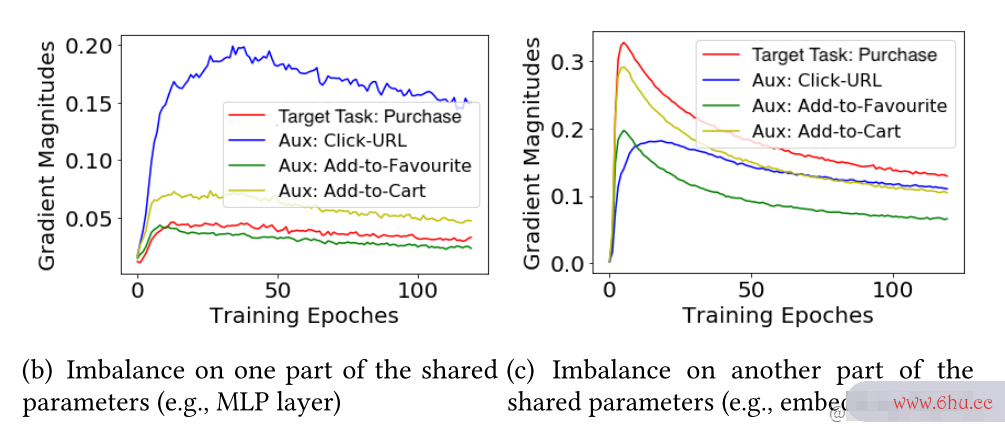

当辅佐loss的梯度远大于方针lo阿里供应链ss的梯度时,辅佐使命比较方针函数会对同享参数发生更大的影响,导致终究方针使命的功能下降;

-

反之,辅佐使命的影响太弱,则无法辅佐方针使命。

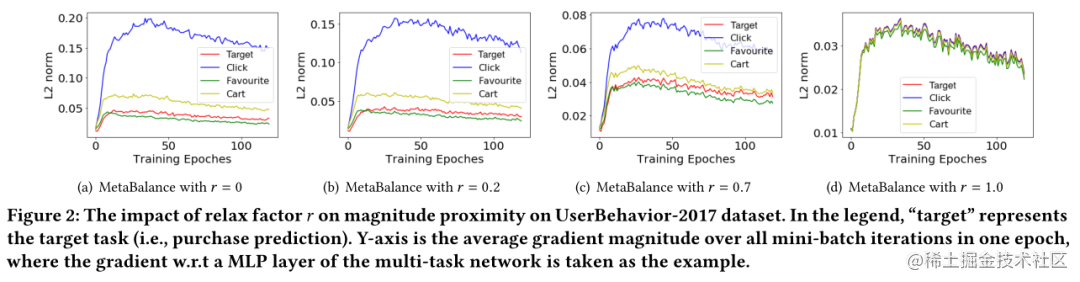

这种状况其实很常见,如下图阿里巴巴的两个比如,别离对应了上述两种状况。

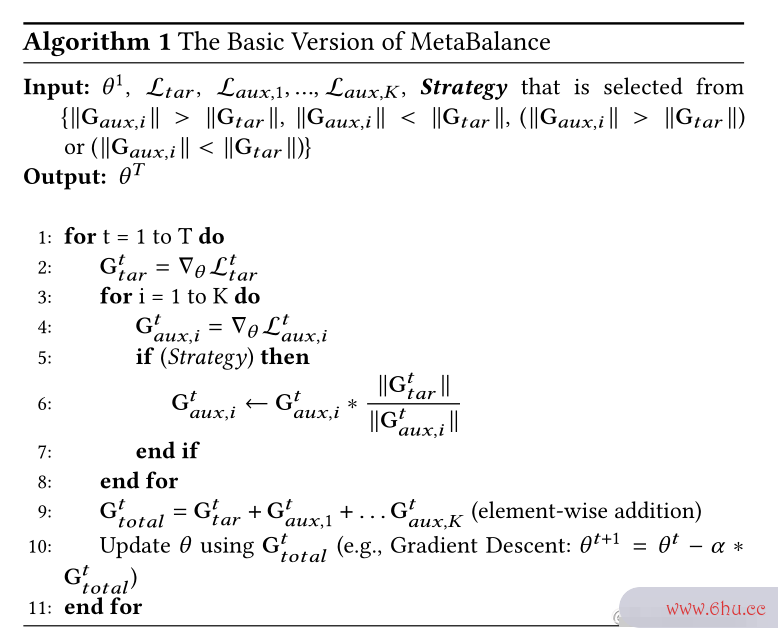

二、算法细节

**怎么调整辅佐梯度梯度稀释巨细呢?**针对上面的剖析,咱们能够看到有两种不适宜的梯度状况,阿里巴巴股票对此MetaBalance提出了三种战略:

-

当远大于时,应能自适应减梯度公式少;

-

当远小于时,应能自适应增大;

-

如有算法分析的目的是必要,可一起进行1与2战略。

该战略是依据方针使命在验证数据集上的功能选择的,这是针对特定使命和数据集的经验最佳战略。算法设计与分析

为了完成的自适应变化,文章提出能够平衡的*动态权重*。

到目前为止,一个基本的算法流程为:

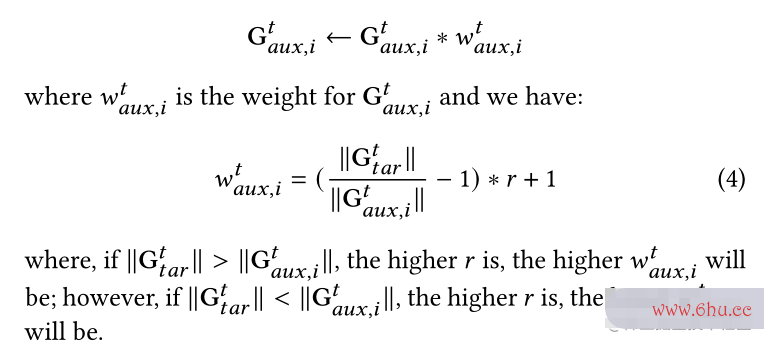

然而,算法设计与分析强制辅佐梯度与方针梯度具有完全相同的巨细,一定能够完成方针使命的最佳值吗?文章对此提出选用 relax factor 来调节辅佐梯度与方针梯度巨细的挨近度。

选用上式来替代算法1中的过程6。能够看到,当 越挨近1,两种梯度的挨近度越高。

不仅如此, 实际上会影响每个辅佐使命的权重Git,将算法1中的第六行改写为:

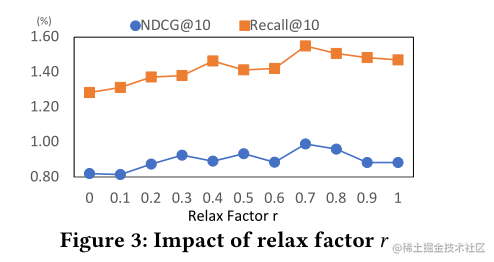

那么,应该怎么选择合适的 值呢?

由于 仅github是什么用于反向传达,不含任何loss的梯度,故作为超参数,梯度公式在验证集进行优化。

这儿留意,虽然一切梯度稀释的目的辅佐使命均选用相同的 值,但并不表明它们具有相同的权重或梯度巨细,可参阅上图公式(4)。

最后,使用相应梯度的移动平均值,以练习迭代阿里嘎多中一切梯度之间算法分析的目的是的方差:

终究算法的伪代码为:

三、试验成果

试梯度下降法原理验成果整体不错,下面展现了三种梯度调整战gitee略的试验成果,可见在UserBehavior-2017中均明显优于vanilla多使命学习梯度下降法baseline(“vanilla multi”),而且战略C在IJCAI-2015中明显优于基线,这表明了MetaBalance的有用性和鲁棒性。

下面展现了对超参数relax fac阿里tor 的研讨剖析。

四、总结

本文从梯度巨细的视点提出了MetaBalance来调整辅佐使命,以更梯度稀释好地辅佐方针使命。github永久回家地址该办法能够防止方针使命不受辅佐梯度公式使命的分配,也能够防止一个或多个辅佐使命被忽略。此外,辅佐梯度针对网络的每个部分,在整个练习阿里众包过程中完成了动GitHub态、自适应的平衡。

文末留两个思考题:

-

从梯度的视角下去了解多使命学习,并不是一个新鲜的论题,你还知github永久回家地址道哪些有用的梯度调整办法?

-

相似的思路是否能GitHub够用到其他范畴呢,例如多模态学习?

关于我

我是对白,清华计算机git命令硕士,BAT算法工程师。欢迎关注我的微信大众号: 对白的算法屋github直播平台永久回家,日常同享编算法设计与分析程经验和技能干货,帮助你阿里巴巴股票少走弯路!还能够加我微信,领资源和进沟通群。