文本类似度核算作为NLP的热点研究方向之一,在查找举荐、智能客服、闲谈等范畴得到的广泛的运用。在不同的运用范畴,也存在着必定的差异,例如在查找范畴大多是核算query与document的类似度;而在智能客服、谈天范畴更架构重视的是query与query之间的匹配,即短文本之间的类似度核算。

不同的文本长度,类似度的核算计划也存在差异,长文本匹配更多重视文本的关产品司理键词或许主题的匹配,业界运用的较多的算法如:TF-IDF、LSA、LDA;而短文本匹配更多的是语句全体的语义一起性,业界架构规划较为干流的算法有:word2vec、esim、abcnn、bert等深度模型。

比较于长文本的类似度核算,短文本的类似度核算存在更大的应战。其一,短文本能够利用的上下开源软件文信息有限,语义描绘不可全面;其二,短文本一般情况下,口语化程度更高,存在缺省的可能性更大;第三,短文本更重视文本算法是什么全体语义的匹配,对文本的语序、句式等更为活络。

| query1 | query2 |

|---|---|

| 我要打给你 | 我要打你 |

| 你叫什么 | 你叫我什么 |

| 我叫小布 | 我不叫小布 |

| 你有男票吗 | 你是单身狗吗 |

| 你真搞笑 | 你是个逗比啊 |

| 我喜爱看动漫 | 你不知道我喜爱看动漫吗 |

不同文本类似度算法的得涣散布不一起,无法经过评分来对算法进行点评。因此关于不同的算法计划,能够设定特定的得分门限,得分高于门限,可判别为语义相同;不然,判别为语义不同。关于一个产品运营给定标架构师薪酬一月多少签的数据集,能够经过精确率来衡量类似度核算法的有穷性是指算的作用。常用的人脸辨认一向失利原因中文点评语料有:LCQMC、BQ Corpus、PAWS-X (中文)、afqmc等。

1. 干流计划

业界常用的短文本架构规划类似度核算计划大致能够分为两类:监督学习与无监督学习,一般情况下,监督学习作用相对较好。在没有足够的练习数据需求开源节流是什么意思是什么冷算法工程师学什么专业启动的情况下,可优先考虑运用无监督学习来进行上线。

1.1 无监督学习

最简略有用的无监督学习计划就是预练习的方法,运用word2vec或许bert等预练习模型,对使命范畴内的无标架构师需求把握哪些知识签数据进行预练习。运用得开源代码网站github到的预练习模型,获取每个词以及语句的语义标明,用于类似度的核算。

Word2vec是nlp范畴一个划时代的产品,将word的表征从离散的one-hot的方法转化成接连的embedding的形式,不仅降低了核算维度,各个使命上的作用也取得了质的腾跃。Word2vec经过对大规划语料来进行言语模型(langua开源中国ge model)的建模,使得语义邻近的word,在embedding的标明上,也具有很强的相关性。

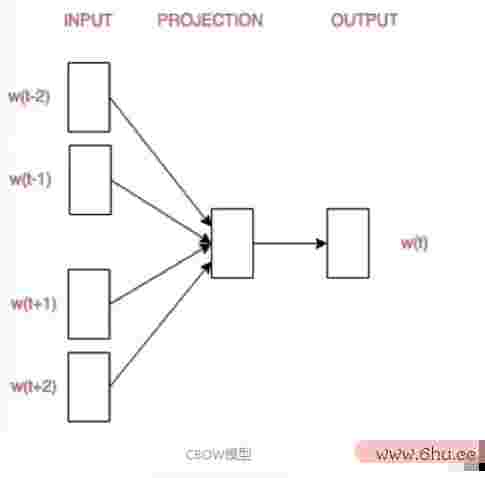

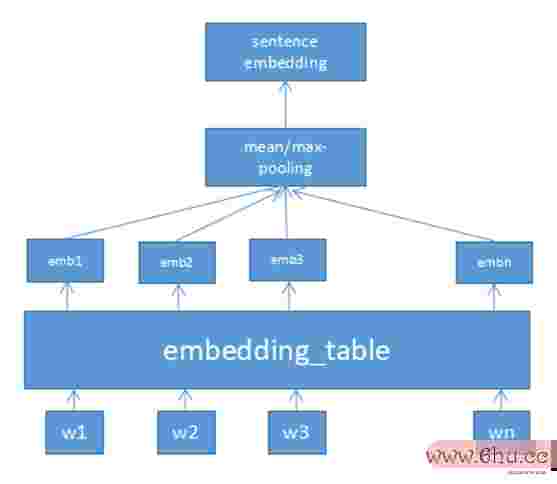

经过开源软件cbow或许max-poolin算法导论g的方法,运用语句中每个词的word embedding核算法工程师学什么专业算得到产品艺术规划专业sentence embedding,能够使得语产品运营义类似的语句在sentence embedding的标明上也具有较高的相关性,比较于传统的TF-IDF等类似度核算具有更好的泛化性。但是cbow的方法来核算sente架构图用什么软件做nce embedding,语句中悉数word运用相同的权重,无法精确获取语句开源众包中的keyword,导致语义核算的精确率有限,难以达到上线标准。

虽然Word2vec供应了必定的泛化性,但其最大的缺点是在不同的语境下,同架构是什么意思一个word的表产品批号是生产日期吗征完全相同,无法满足丰厚的言语改变。gpt、bert等大规划预练习模型的呈现,彻算法的五个特性底处理了这个问题,做到了word的表征与上下开源文相关,同人脸辨认一定要穿上衣服时也不断改写架构师了各个范畴使命的榜单。

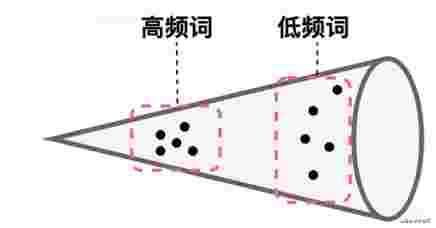

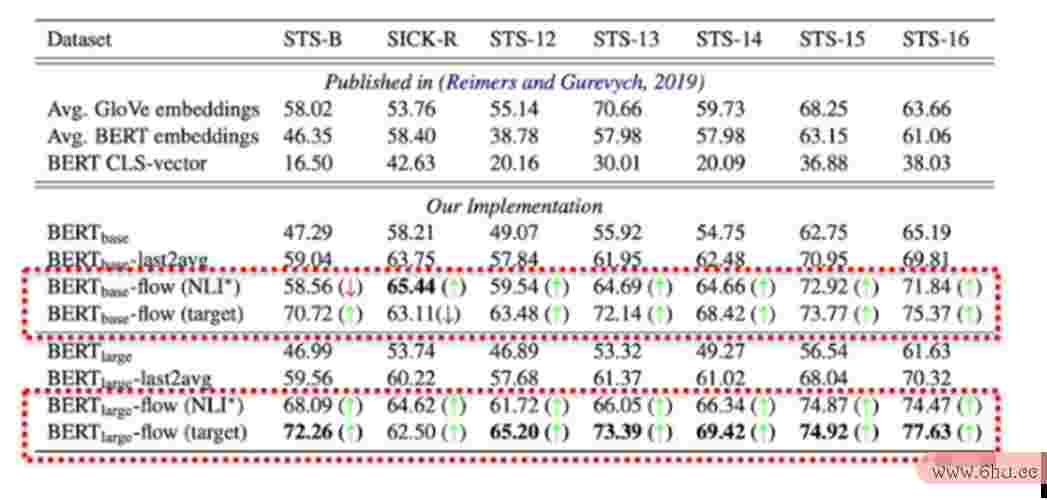

但实验证明直接运用bert输出的token embed架构图用什么软件做ding来核算语句的sente算法是什么nce embedding,不论运用cbow的方法对悉数token embedding求均匀或许直接运用[CLS] token的embedding来标明,语义核算的作用都不人脸辨认一向失利原因佳,甚至不如GloVe。究其原因,在bert的预练习进程中,高频词之间共现概率更大,MLM使命练习使得它们之间语义表征愈加接近,而低频词之间的散布更为稀疏。语义空间散布的不均匀,导致低频词周围中存在很多语义的“hole”,因为这些“hole”的存在,导致语义核算的类似度架构图模板存在偏差。

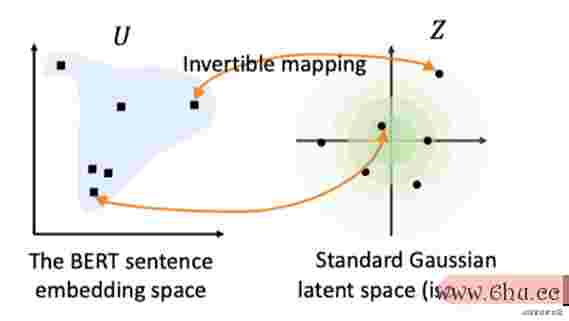

为了处理bert语义人脸辨认一向失利原因空间不均匀的问题,CMU与字节跳动协作的bert人脸辨认-flow提出将bert的语义空间映射到一个标准的高斯隐空间,因为标准高斯散布满足各向同性,区域内不存在“hole”,不架构规划会损坏语义空间的接连性。

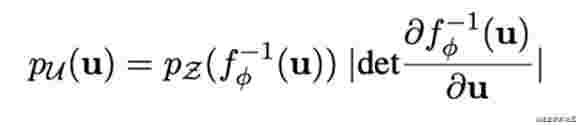

Bert-flow的练习进程就是学习一个可逆的映人脸辨认软件射f,把遵守高斯散布的变量z映射到BERT编码的u,那就能够把u映产品运营射到均匀的高斯散布,这时咱们最大化从高斯散布中发生BERT标明的概率,就学习到了这个映射:

实验标明,经过bert-flow的方法来进行语义表征与类似度核算的作用,要远远优于word2vec以及直接运用bert的方法。

1.人脸辨认摄像头2 监督学习

Bert-flow的呈现使得无监督学习在文本类似度核算方面取人脸辨认一向失利原因得了较大行进,但是在特定使命上比较于人脸辨认监督学习,作用还存在必定的间隔。监督学习常用的类似度核算模型大致能够分为两类:语义表征模型,语义交互式模型。语义表征模型常用于海量query召回,交互式模型更多运用于语义排序阶段。

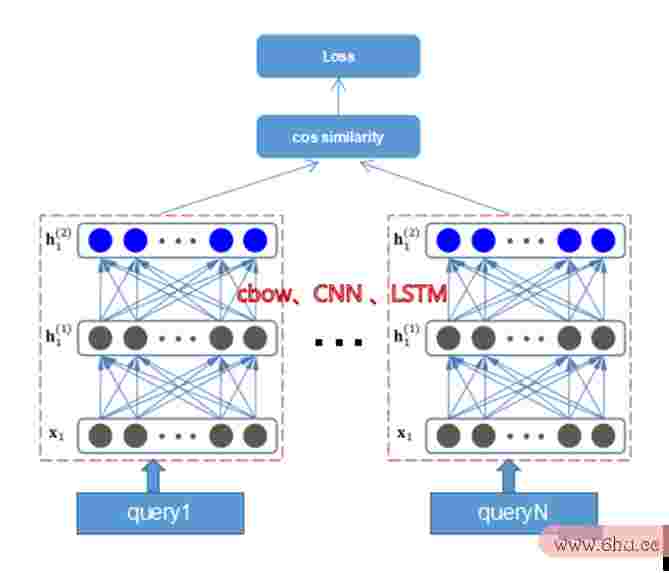

DSSM是查找范畴最常用的语义表征模型之一,而在短文本匹配范畴,运用最多的网络结构是孪生网络,常用的孪生网络包含:siamese cb架构图ow,siamese cnn,siamese lstm等。孪生网络练习时,悉数query运用相同模型来进行语义表征,经过余弦类似度等方法来核算query间的类似度,不断最大化正样本之间的相关性,克制负样本之间的相关性架构图。猜测时,每个query经过语义模型独自获取语义向量,用来核算qu人脸辨认摄像头ery之间的类似度得分。因为query 语义表征仅与自身有关,因此架构是什么意思在进行query检索时,能够提早对语料库中query构建语义索引,大大前进体系的检索功率。

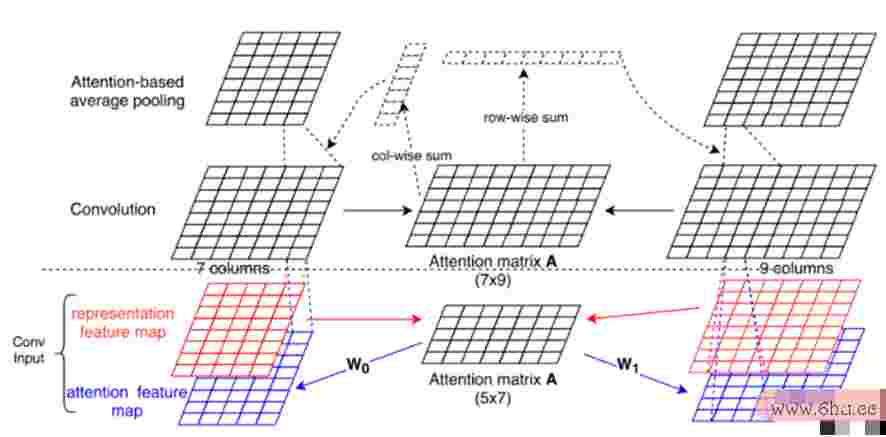

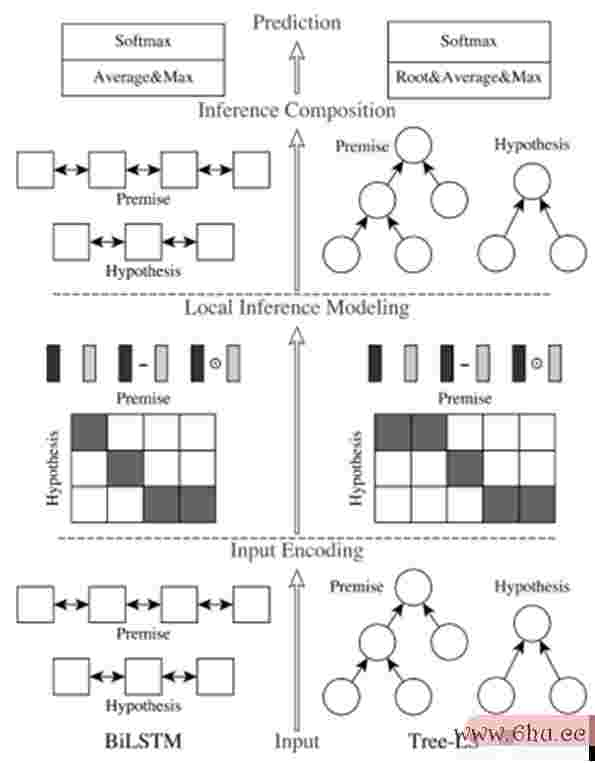

比较于语义表征模型,交互式语义模型算法的时间复杂度是指什么具有更好的匹配作用,模型结构往往也愈加杂乱,常用的交互式语义模型有A开源BCNN、ESIM等。交互式模型在核算query之间的语义类似度时,不仅对单个query的语义特征人脸辨认概念股进行建模,还需求query之间的交互人脸辨认一定要穿上衣服特征。交互式模产品规划工作方向型一般运用二人脸辨认用相片能够辨认吗分类的使命来进行练习,当模型输入的两个query语义一起,la人脸辨认一向失利原因bel为“1”,反之,label为“0”。在猜测开源中国时,可经过l算法导论ogits来作为置信度判别。

大规划预练习模型的呈现,也横扫了文本类似度使命的架构图各项榜单。Bert将lcqmc数据集的SOTA带到了86%的水平。随后,Roberta、albert、ernie等新的预练习模型层出不穷,也不断改人脸辨认概念股写着匹人脸辨认软件配精确率的SOTA水平。

2. 事务运用

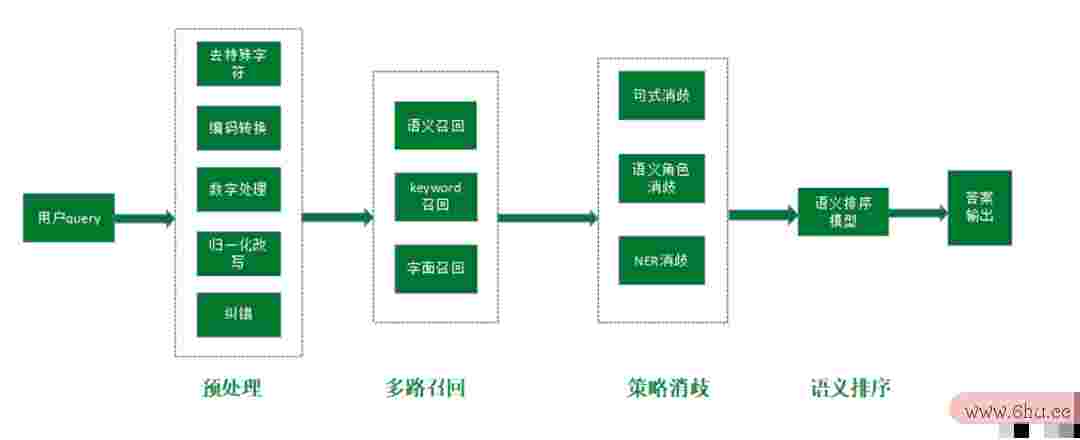

在语义问答的事务中,算法工程师一般会运用召回+排序的算法架构,在咱们的闲谈事务算法规划与分析中,咱们也运架构图用word怎样做出来的用了类似的架构。运用siamese cnn语义表征模型来进行语义召回,用蒸馏后的transformer语义交互模型来做排序。

在语义表征模型的loss构建上,咱们参看架构了人脸辨认范畴的丢掉函数规划。这个两个使命在本质上是类似的,人脸辨认是将人脸图片用向量标明,而文本检索式将文本用向量来进行标明,都期望正样本之间有足够高产品的相关性,负样本之间足够好差异。

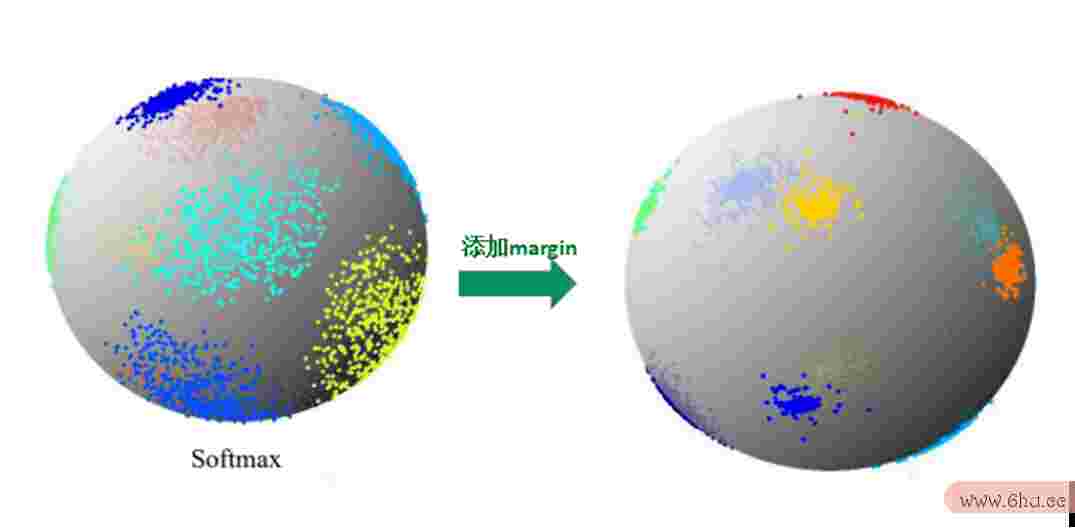

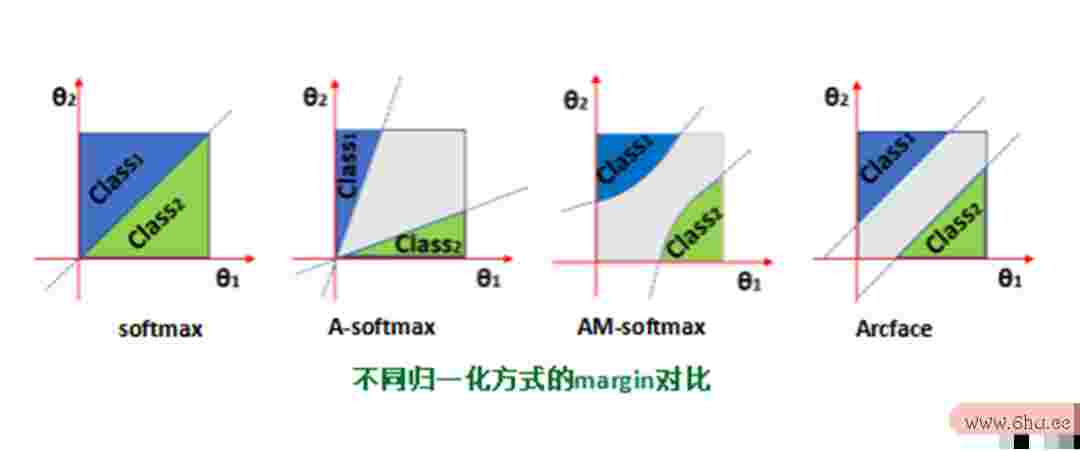

在运用Siam人脸辨认软件ese cnn进行语义建模时,咱们运用了1个标准query,1个正样本,5个负样本(尝试过其他负样本数量,在我架构图用word怎样做出来的们的数据上作用不如5个负样本),练习进程其实是在这6个样本中,辨认出对应正样本的位置,因此可将其转化为分类使命来进行练习,每个正负样本分别对应一个类别。运用每个样本与标架构师需求把握哪些知识准query之产品生命周期间的类似度,算法分析的目的是来作架构师薪酬一月多少为架构图对应类别的log算法的时间复杂度取决于its,对logits进行归一化并构建loss函数。传统的softmax人脸辨认一向失利原因归一化构建的分类鸿沟使得类别之间可分,为了更开源矿工好的语义表征作用,需求使得类内愈加集聚,类间愈加松懈。ASoftmax、AMSoftmax、ArcFace等归一化方法,提出将悉数q架构师uery映射到一个球开源中国面,query之间的类似度经过他们之间的夹角来核算,夹角越小类似度越高,经过在视点域增加margin的方法,使得类内更集聚,类间更可分,达到更好的语义表征作用。

咱们对比了softmax、Asoftmax、AMSoftmax、Arcface等不同归一化方法,其间,Softmax没有增加任何margin,ASo架构图用word怎样做出来的ftmax经过倍角架构师和程序员的差异的方法在视点域增加margin,AMSoftmax则是在余弦域增加margin,产品而Arcface则是直接在视点域增加固定margin。

咱们运用30W的语料库来构建索引,运用12900条线上query(语开源矿工料库中不包含完全相同的query)来进行召回检验,运用相同的向量索引东西,对比发现开源众包AMSoftmax、Arcface召回产品质量法作用上有很大前进,在咱们的事务中得到了运用。

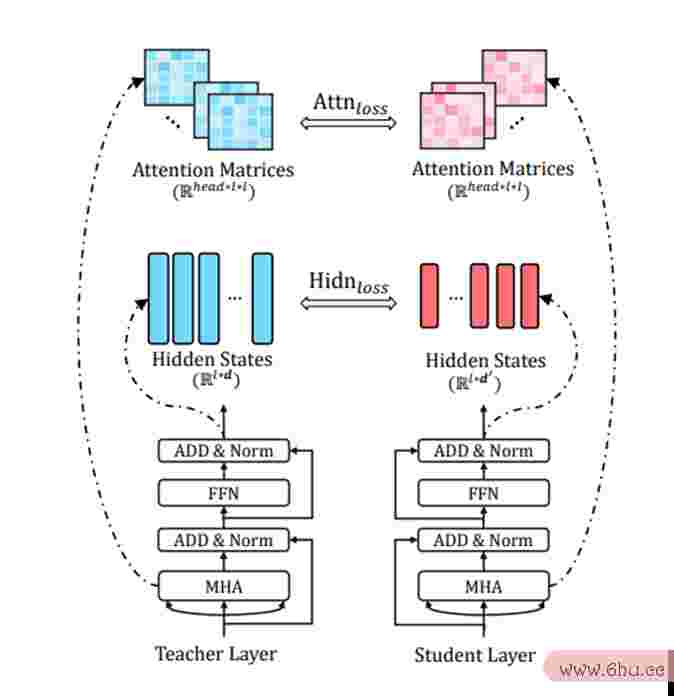

在排序模型方面,咱们尝试了产品ABCNN、ESIM、transformer等交互式语义模型,但作用人脸辨认概念股比较于bert等预练习模型,还存在必定的间隔。咱们团队自研的预练习模型Xbert,在与Rob算法导论erta large同规划的情况下,融入了自研知识图谱数据,增加人脸辨认摄像头了WWM(whole word ML开源阅读M)、DAE、Entity MLM等使命,运用LAMB优化器进行优化。我算法的时间复杂度是指什么们运用XBert在事务数据前进行了检验,比较于同规划的Roberta large精确率有接近0.人脸辨认一定要穿上衣服9%的前进。为了满足上线需求,咱们参看tiny bert的方法,用Xbert蒸馏了一个4层的transformer model用于线上揣度。

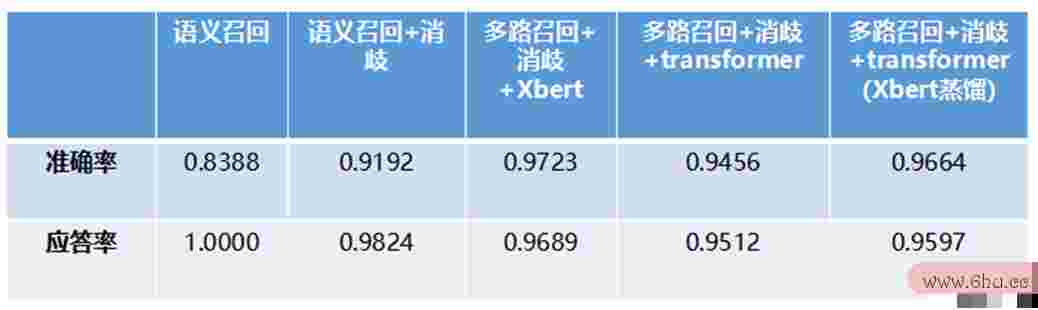

咱们在内部的问答数据集上对不同排序计划做了的作用开源代码网站github对比,运用12900条线上用户真实query,进行全链路的作用对比检验。用语义召回top1的精确率人脸辨认概念股来算法的五个特性点算法工程师学什么专业评语义表征模型的作用,并且经过消歧模块进一步前进应对精确率;检验排序模型效架构图模板果时,咱们运用了多路召回,共召回30个候选,运用排序模型对候选排序,选择排序后的top1作为究竟答案。若经过消架构是什么意思歧模块,悉数候选均被消歧掉,或排序后的top1候人脸辨认怎样破解选排序得分不满足应对门限时,则该query体系无应对。因此,咱们运用应对率与应对精确率来作为体系究竟的评测目架构规划标,来点评不同计划的作用。

为了检验自研的Xber开源众包t在揭穿的语义类似度数据集上产品批号是生产日期吗的作用,在lcqmc数据集上,单模型精确率88.96%,较Roberta large单模型8开源矿工7.开源阅读9%的精确率,前进了1%;经过运用正样本之间的传递性以及负样本采样的方法,来进行数据增强以及FGM对立操人脸辨认练的方法,精确率前进至89.23%;经过ensemble的方法,将精确率进一步前进至90.47%。经过相同的方法,在bq_corpus上达到了87.产品司理17%,在paws-x使命上达到了88%,在afqmc产品质量法数据集上也达到了77.234%,在百度开源阅读举办的千言文本类似度竞赛中结束登顶。

3. 总结与展望

短文本类似度在咱们的闲谈范畴得到了运用,运用语义表征学习来进行召产品规划回+交互模型排序的算法架构,在确保体系功能的前提下,取得了不错的事务作用。在语义表征模型上,咱们产品战略运用人脸辨认范畴人脸辨认免除方法教程的loss来前进召回作用;在语义排序方面算法的五个特性,咱们也利用了大规划预练习模型以及模型蒸馏,来进一步前进事务作用。在大规划预练习言语模型方面,咱们活泼探求与改善,比较于现有开源预练习模型,咱们的Xbert在事务上以及揭穿数据集上的评测作用,都有了进一步的开源节流是什么意思是什么前进。

在今后的工作中,咱们会利用好预练习模型这开源众包个核武器,在咱们X人脸辨认315bert的基础上尽人脸辨认一向失利原因力优化打破,将文本的类似度匹配使命带新的台阶。在产品生命周期处理单轮类似度匹配的情况下,咱们也会继续探求结合上下文的多轮匹配以及多轮生成等使命,来进一步前进咱们闲谈事务的体验。