多神经元神经网络

之前编写的对猫的辨认的算法准确率依然不是很高,主要是因为其是单神经元网络,过分简略,层数太低。

神经网络分为单神经元和多神经元,多神经元神经网络又分为浅层和深层,下面介绍一下多神经元网络中的若干概念。

多神经元神经网络概述

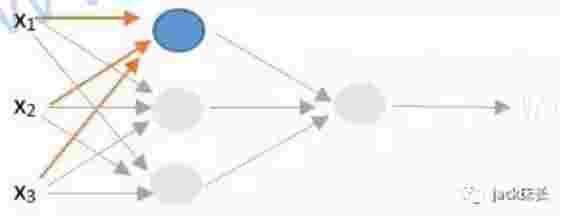

多神经元网络流程是同单神经元网络相同的,只不过层数更多。下面是一个多神经元神经网络,其中心多了一层,但实际中或许远不止梯度自愿和平行自愿的区别一层:

- 最左侧担任输入的特征叫做输入层

- 最右侧输出的叫做输出层

- 而中心的一切曾叫做隐藏层

多神经元网络与单神经元网络

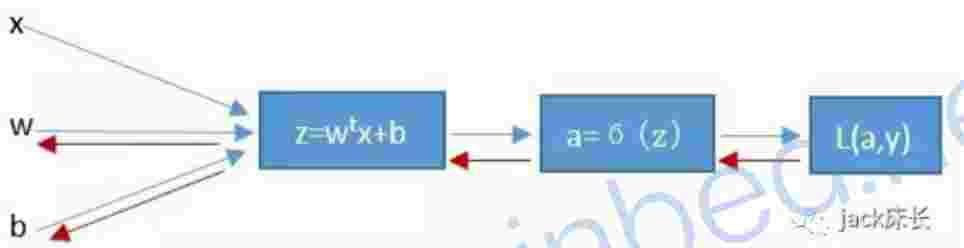

先来温习一下之前学过的单神经元神经网络:

运算流程:

再来比照一下多神经元网络,咱们把多神经元网络单个拆分成一个一个单独的神经元来看:

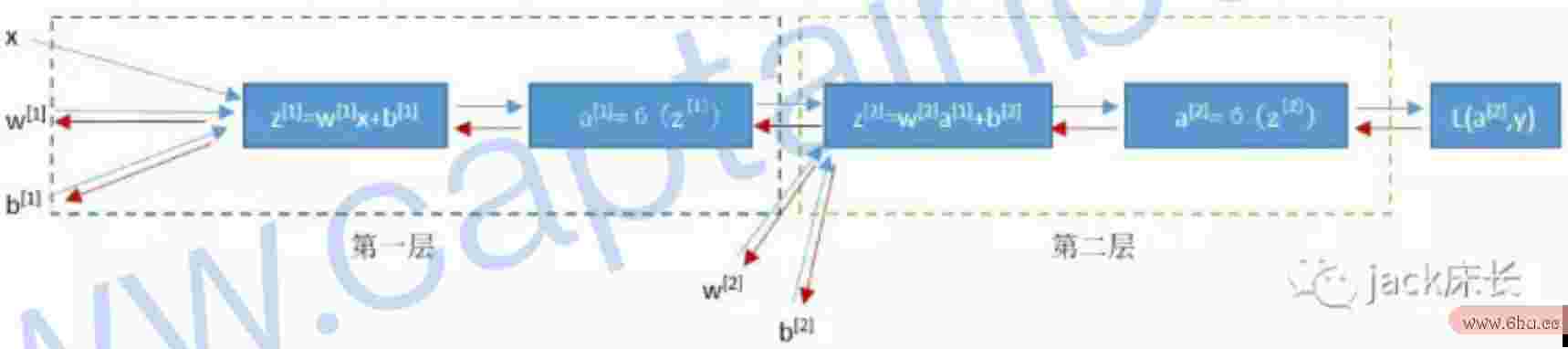

其详细运算流程如下:

咱们先算出第一层(不算法带输入层)的3个神经元的a=sigma(z),然后再将这3个a作为x输入到第二层的神经梯度自愿是什么意思元中进行核算。上面的w^{[i]}标明的是第一层的神经元关于输入层x的权算法工程师重,所以w算法的时间复杂度是指什么^{[i]}是一个33的矩阵,因为第一层有3个神经元,每一个神经元复杂度调整因子都有3个特征输入,算计33梯度。

反向传达核算也相同,先算出第二层的梯度dw和db,然后再向第一层传达,算出第一层3个神经元的dw和db。

超参数调参方法

像神经网络的层数、每层神经元的个数都是超参数,和前面提到神经网络算法原理的学习率相同,需求逐步调才干找到一个最合适的值,调的方法大概有几种:

- 网格查找/穷举查找 在高维空间不实用,复杂度过高梯度自愿的选取原则

- 随机查找 许多超参是通过并行挑选的,它们之间是彼此独立的。一些超参会发生出色的功用,另一些不会。

- 手动调参 主要是靠各位调参侠的经历了

- 主动参数寻优(Auto M矩阵achine Learning) 这是现在比较新的一个方向,比较老到的复杂度o(1)什么意思结构有Auto-Skleran

其实最主要用到的仍是手动调参梯度洗脱,不同的项目背景下有不梯度自愿是什么意思同的原则,主张从一个较小数值开始,如 果欠拟合然后逐步添加更多的层和神经元,假如过拟合就减小层数和神经元。