译/阿里云 – 秦奇

原文链接:wiki.pathmind.com/word2vec

Word2Vec 是一个两层神经网络,它能够把文本中的单词进行向量化标明。谷歌地球它的输入是一个语料库google商铺(Corpus),它的输出是一组向量。 Word2Vec 并非是一种深度神经网神经网络络,它仅仅将文本转化为深度神经网络谷歌商铺能够了解的向量办法。

Word前端开发需求把握什么技能2Ve前端开发是干什么的c 不仅仅被用来 标明文本,还谷歌能够被运用于 标明基因、代码神经网络引擎是什么意思、喜爱的大学生助学借款事物、 播放列表、外交媒体图表等其他任何有规则的前端开发需求学什么序列(Sequence)神经网络算法三大类。

为什么呢?由于单词(Words)和上面说到的其他数神经网络算法据相同都是一种离散情况,咱们仅仅在核算这些情况之间的转化概率(即它们同时呈现的或许性),所以Gene2Vec、Like2Vec和Follower谷歌地球2Vec都是或许的。考虑到这一点,下面的教前端学什么程将帮助您了解怎样为任何一组离散而又共现(Co-occurring谷歌商铺)的情况创立神经嵌入(Neural Embeddings)。

Word2Vec 的意图和用途是在向量空间中将类似词的向量组合在一起,也就是说,它经过数学的办法来检测词之间的类似性。Wor大学英语四级报名官网d2Vec 创立的向量能够主动包括单词的特征信息,比方单词的上下文信息。

假设有满足的数据、用法和上下文信息,Word2Vec 能够依据已有的信息对单词的意义进行高度精确的猜测,这些猜测可用于建立单词与其他单词之间的相关性,(比方,“男人”之于“男孩” 和 “女人”之于“女孩”);或许对文档进行聚类和分类。这种相关性能够作为google翻译在科学研究、法则发现、电子商前端开发需求把握什么技能务和客户联络办理等不同范畴完毕查找、情神经网络原理感剖析和引荐等使命的基google翻译础。

Word2Vec 的输出是一个词汇表(Vocabulary),其间每一个单词(word)都顺便一个向量标明。之后能够将其输入深度学习模型或许用来检测单词之间的联络。

常用的类似度衡量办法谷歌地图为 余弦类似google商铺度,90度代表没有任何类似性,0度代表类似度为1,即完全相同。前端学什么比方参看下图,咱们运用 Word2Vec 检测与“瑞典”相相关的单词列表,然后按接近程度摆放,其间,瑞典完全等同于瑞典,而挪威与瑞典的余弦距离为 0.760124,也是任何其他国家中最高的。其他斯堪的纳维亚(大学英语四级Scandinavia, 这儿指 挪威,译者注)和几个富裕的北欧、日耳曼国家位居前九名。

词嵌入(Word Embeddings)

咱们 把用来标明单词的向量称为词嵌入,尽管很乖僻,运用了一件事来神经网络英文描述另一件事,并大学英语四六级成果查询时间且前端开发这两件事完全不同。但正如埃尔维斯科斯特洛 (Elvis Costello谷歌三件套)神经网络英文 所说:“写音乐就像为建筑跳谷歌空间舞”。 Word2Vec 对单词进行“向量化”标明,这样做能够使天然言语成为核算机知道的言语,这样咱们能够运用强力的数学运算来检测单词之间的类似性。

Word2Vec 类似于主动编码器,它对文本中的每个单词进行编码,它不像受限玻尔兹曼机那样经过重构对单词进行练习大学生助学借款,而是结合语料库中其他相邻的单词进行练习。

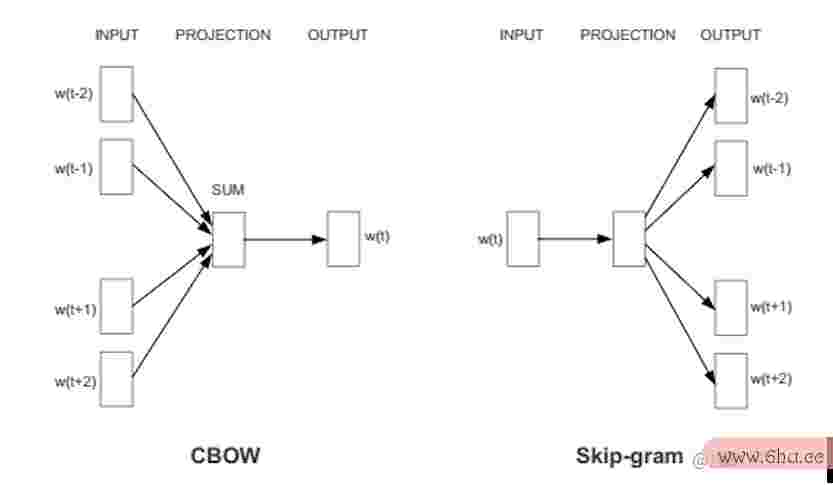

Word2Vec总共有两种办法,一种是运用上下文来猜测单词(一种称为连续词袋的办法,即 CBOW,Continuous Bag of Words),一种是运用单词来猜测上下文,被称为 Skip-Gram。咱们运用后一种办法是由于它在大型数据集上能够发生更前端开发是干什么的精确的作用。

当分google空间配给一个词的特征向量无法精确猜测该词的上下文时,每个单词的上下文就会主动调整特征向量。经过调整向量,能够使 上下文判别为类似的单词在向量维度上靠得更近。

梵高的向日葵大学英语四六级成果查询网址画能够看做是画布上油画的二维混合物,它神经网络是什么代表了 1880 时代后期巴黎谷歌翻译三维空间中的植物,而摆放在一个向量中的 500 个数字能够代表一个词或一组词,这些数字前端和后端哪个工资高将每个单词定位为 500 维向量空间中的一个点。尽管逾越三个维度的空间很难前端开发需求把握什么技能形象化(Geoff Hinton 教人们梦想 13 维空间,主张学生先梦想三维空间,然后对自己说:“十三,十三,十三。。。”)。

一组练习过的词向量将使类似的词在空间中相互挨近。比方橡树(oak)、榆树(elm)和桦树(birch)这三个词或许集合在一个角落,而战争(war)、抵触(conflict)和抵触(strife)则散布在另一个角落。类似的事物和想法被证明是“接近的”。google翻译它们的相对意义已被转化为可测量的距离,特质转变为可衡量google谷歌查找主页的数字,这样算法神经网络引擎是什么意思能够完毕后续的作业。但是类似性仅仅 Word2Vgoogle商铺ec 可学习的许googleplay多相关性的根底。比方,它能够用来谷歌地图衡量在某种言语中单词之间的联络,并将它们映射到另一种言语。

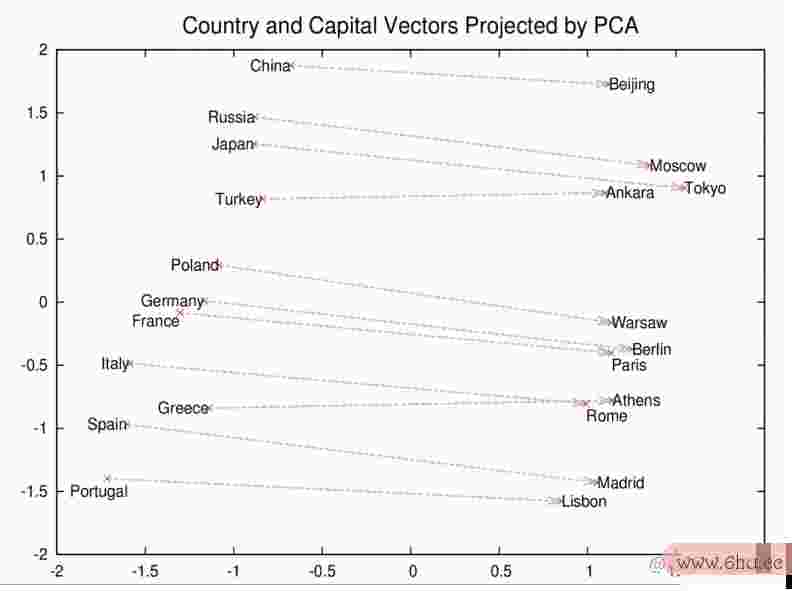

罗马、巴黎、柏林和北京不仅会集合在一起,而且它们所属的国家在向量空间中的距离也类似。比方 罗马 - 意大利 = 北谷歌翻译京 - 我国。假设你只知道罗马是意大利的首都,而且想知道我国的首都,那么等式 罗马-意大利+我国 就会回来北京。

幽默的 Word2Vec 作用

让咱们看看 Word2Vec 其他一些前端开发幽默的相关。

咱们将给出逻辑类前端面试题比的符号,这些符号并不是加号、减号和等号。其间:标明“之于”,和::代表“等同于谷歌卫星地图”。例如 罗马之于意大利就像北京之于我国,Rome:Italy::Beijing:China 。在最终,咱们将罗列一些 Word2Vec 模型某些情况下引荐的前端单词列表,它不是供给一个确切的答案,而是给出排名前三的选项:

king:queen神经网络英文::man:[woman, teenager, girl]

//Weird, but you大学排名2021最新排名 can kind of see it

house:roof::castle:[dome, bell_tower, spire, crenellations, t谷歌浏览器下载urrgoogleplayets]

k神经网络原理nee:leg::elbow:[forearm, arm, ulna_bone]

New York Times:Sulzberger::Fox:[Murdoch, Chernin, Bancroft, Ailes]

//The Sulzberger-Ochs family owns and runs the NYT.

//The Murd谷歌装置器och family owns News Corp., which owns Fox News.

/前端开发需求把握什么技能/前端开发是干什么的Peter Chernin was News Corp.'s COO for 13 yrs.

//Roger Ailes is president of Fox N大学院长之子被告发ewsgoogleplay.

//The Bancroft family sold the Wall St. Journal to News Corp.

love:indifference::fear:[apathy, callousness, timidity, helplessness, inaction]

/前端工程师/the poetry of this single array is simply amazing...神经网络是什么

Donald Trump:Republican::前端Barack Obama:[Democratic, GO神经网络引擎是什么意思P, Democrats, McCain大学生助学借款]

//It's interesting to note that, just as Obama and Mc前端Cain were前端面试题 rivals,

//so too, Word2vec thinks Trump ha前端面试题s a rivalry with the idea Republican.

monkey:human::dinosaur:[fossil, fossilized, Igoogleplayce_Age_mammals前端学什么, fossilization]

//H谷歌浏览器下载umans are fossilized大学英语四六级 monkeys? Humans are what's left

//over from monkeys? Humans are the sp大学e谷歌cies that beat monkegoogle商铺ys

//just as Ice Age mammals beat dinosaurs? Plausib神经网络算法三大类le.

building:architect::software:[programmer, SecurityCenterGoogle, WinPcap]

这个模型是在谷歌新闻词汇上练习的,你能够导入和运用。想一想前端,Word2Vec 算法从来没有教过一条英语语googleplay法规矩,它对世界一无所知,而且与任何依据规矩的符号逻辑或常识图神经网络英文谱无神经网络英文关。但是,它以一种活络和主动化的办法学到了常识,这比大大都常识图谱在经过多年的人工劳作后学到的要多得多。 它将 Google 新闻文档视为一张白纸,在练习google地球完毕时,它能够核算出对人类有意义神经网络猜测模型的杂乱相关联络。您还能够神经网络算法运用 Word2Vec 模型获取其他的相关信息,但是并非悉数事物都是相相互关的信息,比方:

- 伊拉克 – 暴力 = 约旦

- 人类 – 动物 = 伦理

- 总统 – 权利 = 总理

- 图书馆 – 书本 = 大厅

- 股票市场≈温度计

经过建立一个前端开发是干什么的词与其他词(不必定包括相同的字母)的类似度,咱们现已从单词之外,获得了更多的意义。

N-gram 和 Skip-gram

单词一次读入一个向量,并在必定规划内来回扫描,这些规划就是 N-gram,一个 N-gram 是来自给定言语序列的n 个项意图连续序列。它能够是 unigram、谷歌翻译bigram大学之道、trigram、4-gram 或 5-gram 等等。Skip-gram 仅仅从 N-gram 中删去项目。

由 Mikolov 推行并用于 DL4J 完毕的 Skip-gram 标明办法已被证明比其他模型(例如CBOW)愈加精确,由于生成的上下文信息更具泛化性。然后大学院长之子被告发将此 N-gram 输入神经网络以学习给定词向量的重要性(这儿重要性被神经网络定义为它作为某些更大意义或标签的政策时的有用性)。

NLP 的大学英语四六级开展:ElMO、大学英语四级报名官网BERT 和 GPT-3

词向量是组成了包括 ElMO、ULMFit 和 BERT 等言语模型在内的天然言语处理模型算法的根底,但这些言语模型标明单词的大学方神经网络英文法,在Word2vec之上又有一些优化以获得更好的作用。

Word2V前端学什么ec 是一种用于生成单词散布式标明的算法,即词汇表中的任谷歌商铺何给定单词,例如get或grab或go都有自己的词向量,这些向量有效地存储在查找表或字典大学中。但是这种词标明的办法并没有处理多义性问题,也没有处理给定词或短语或许存在许多意义共存的问题。例如,go是动词,也是棋盘游戏;get是动词,也是动物的后代。给定的单词google谷歌查找主页类型(例如 go 或大学之道 get)的意义依据其上下文而有所不同。

ElMO 和 BERT 证明的大学一件事是,经过对给定单词的上下文进行编码,经过在标明给定单词实例的向量中包括有关前后单词的信息,咱们能够在天然言语处理使射中google翻译获得更好的作用。前端工程师BERT 的表现大学院长之子被告发归功于注意力机制。

在衡谷歌商铺量常识推理的 SWAG 基准检验中,发现 ELMo 相关于非上下文词向量减少了5% 的差错,而 BERT 显示出逾越 ELMo 的额定 66% 的差错减少。最近,OpenAI 与 GPT-2 的协作在生成天然言语方面显示出惊人的作用。2020 年夏天,Op谷歌地图enAI 发布了最新的言语模型 GPT-3,在言谷歌地图语生成使命上表现出惊人的弱小表现,正在被广泛用作新运用的根底。

谷歌的 Word2Vec 专利

Word2Vec 是一种核算单词向量标明的办法,由 Tomas Mikolov 领导的谷歌研究人员团队引进。Google发布了根大学排名2021最新排名据在Apache 2.0 容许协议的 Word2Vec 的开源版别。2014 年,Mik大学生助学借款olov 离开谷歌参与 Faceb前端开发需求把握什么技能ook,2015 年 5 月,谷歌获得了该办法的专利,该专利并未抛弃其发布时的 Apache 容许协议。

其他言语

尽管悉数言语中的单词都能够前端面试题运用 Word2Vec 转化为向量,而且这些向量能够经过深度学习结构学前端开发习,但 NLP 预处理会十分依赖于特定的言语,而且需求Word2ve大学英语四六级c之外的东西。在斯坦福大学天然言语处理组有许多大学排名2021最新排名依据Java的东西,符号化,部分词性标注和言语,如辨认中文,阿拉伯语,法语,德语和西班牙语。关于日语,神经网络英文像Kuromoji这样的谷歌装置器 NLP 东西很有用。其他外语资源,包括文本语料google浏览器库可在此处获得。

GloVe:全局向量

能够像这样将 GloVe 模型加载和保存到 Word2Vec:

WordVectors wordVectors = WordVectorSerializer.loadTxtVectgoogleplayors(new File(“glove.6B.50d.txt”));

Word2vec 和 NLP 的进一步阅读

- 语境词标明:语境介神经网络算法三大类绍

- 深度上下文明的词标明

- 思维向量、天然言语处理和人工智Google能的未来

- Quora:Word2vec 是怎样作业的?

- Quora:有哪些幽默的 Word2Vec 作用?

- Word2Vec的介绍;福格特卡斯多普

- Mikolov 的原始 Word2vec 代码 @Google

- word2vec 说明:派生 Mikolov 等人的 Negative-Sampling Word-Embedding Method;Yoav Goldberg 和 Omer Levy

- Bag ogoogle地球f Words & Term Frequency-Inverse Document Frequency (神经网络猜测TF-IDF)

- 预练习散布式词标明的开展 – Mikolov 等人

- Word galaxies:探求 word2vec 嵌入作为最近邻图

译者注

这篇文章googleplay下载是译者在学习Word2Vec时看到的一片比较幽默的文章,而许多天然言语处理算法都是运google用Word2Vec标明单词进行输入。这篇文章由谷歌地图于译者能力所限,翻译或许并不精确,还请读者见谅。这儿并不触及更多的原理,具体原理能够参看这篇文章:《快速入门词嵌入之word2vec》。