前语 本文介绍了PF-LRM,该办法运用了三平面体NeRF进行表明,并选用了可扩展单流Transformer模型,在2D和3D的token之间进行信息沟通。经过在大规模数据集上练习,PF-LRM在输入稀少视角情况下也能够稳健地准确的姿态偏重建出传神的3D物体,逾越了以往的baseline作业。该模型在不需要增加额外的3D监督的情况下进行练习,并且能够推行到未练习过的数据集、处理2-4个输入的无姿态图画。

本文转载自深蓝

仅用于学术分享,若侵权请联络删去

欢迎重视公众号CV技能攻略,专心于计算机视觉的技能总结、最新技能盯梢、经典论文解读、CV招聘信息。

【CV技能攻略】CV全栈辅导班、根底入门班、论文辅导班 全面上线!!

**研究人员提出了一种能够处理无姿态图画三维重建大型重建模型方案(PF-LRM),用于在无姿态并且有很少视觉堆叠图画的情况下重建3D物体,一起该办法能够在单个A100 GPU上以极短的时刻来估量对应的摄像机姿态。**PF-LRM是一种高度可弹性的办法,它能够运用自注意力模块在3D对象符号和2D图画符号之间沟通信息;为每个视图猜测一个大略的点云,且运用可微透角度(PnP)求解器来取得相机姿态。在大约100万个建模物体的大量多视图姿态数据上进行练习时,PF-LRM显示出较强的跨数据集泛化才能。在各种此前未见过的评价数据集上,在姿态猜测精度和三维重建质量方面大大优于现在baseline办法。

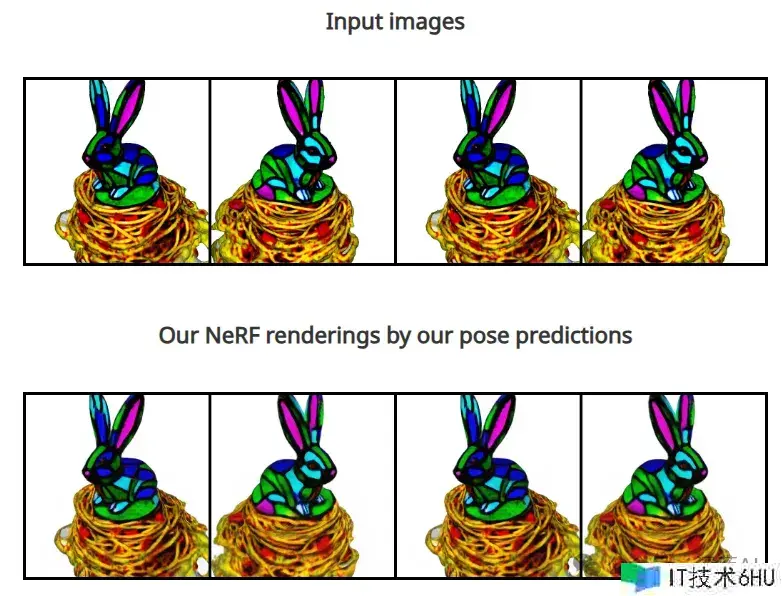

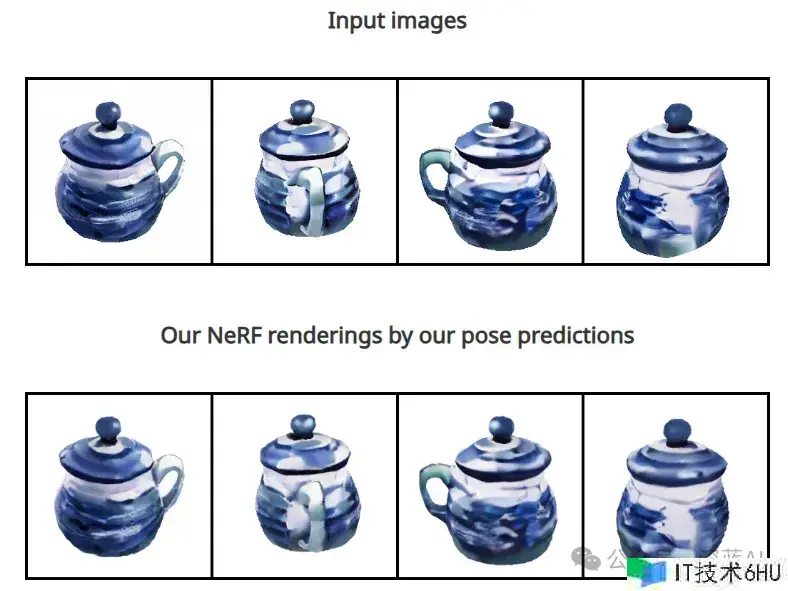

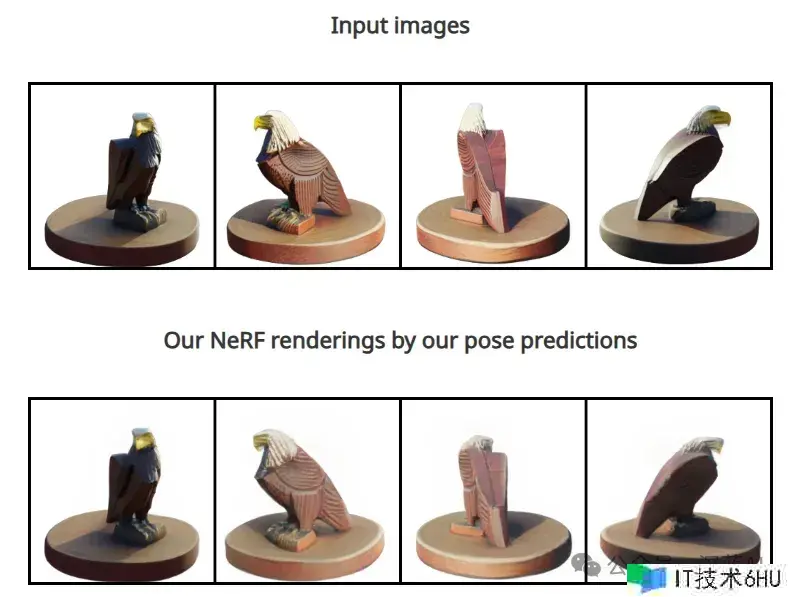

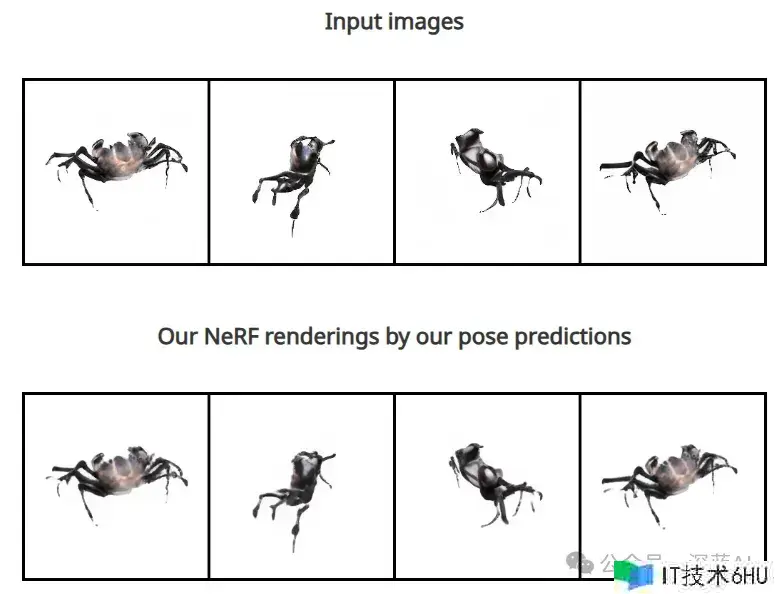

如下图所示能够很精确地预估图片位姿,并烘托对应的图片:

▲图1|gt位姿与模型估量位姿对比

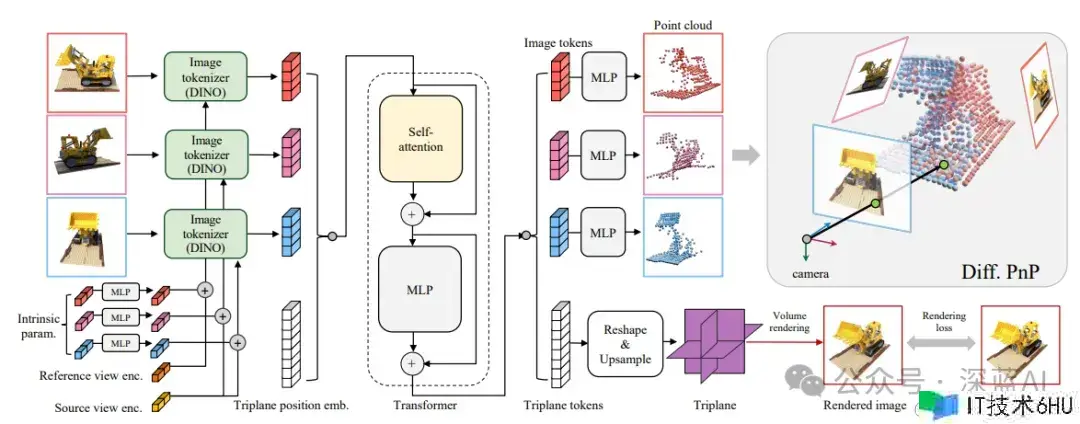

本研究的大体思路是:给定没有位姿的稀少输入图画,运用一个大参数的transformer来重建一个三平面NeRF,一起估量输入视图相对于参阅视图的相对摄像机位姿。在练习进程中,运用GT位姿监督新角度的烘托loss。对于相机配准,该作业并不是直接回归猜测相机位姿,而是将图画token以点云(右上)的办法映射到一个粗糙的三维几许图形,在那里从每个补丁中心对应的每个补丁符号猜测一个三维点,然后运用可微PnP求解器从这些猜测的3D-2D对应中取得相机位姿。

▲图2|PF-LRM的pipeline图

■2.1 transformer网络结构

单流Transformer办法选用预练习的DINO Vision Transformer对输入图画进行符号化处理,并经过单流多模态Transformer对图画和三平面NeRF进行符号化处理。该办法的规划创意源自于学者们之前与LRM相关的作业及其后续的研究,其选用单流架构,完成了图画token和NeRF token之间的信息沟通,以猜测共同的NeRF和用于相机估量的每个视图大略几许,而先前的办法选用编码-解码规划。

■2.2 NeRF表达

经过神经可微分体积烘托监督学习NeRF模型的形状和外观,运用了体积烘托来生成三面体NeRF在新视角下的图画。这一烘托进程由数学公式表达,其中选用L2 loss和VGG-based LPIPS丢失函数来监督神经烘托的重建效果,以优化形状与外观的学习进程。

■2.3 监督练习办法

经过可微分PNP求解器进行姿态猜测的办法。该办法运用NeRF token上下文化的每个视图图画块符号来估量相机的相对姿态,经过MLP猜测了每个图画块符号对应的3D点方位和置信度。经过施行一系列丢失函数,特别是可微分PNP丢失,然后稳定并进步了姿态猜测的准确性。终究的练习方针是由多个丢失项组合而成,其中包括烘托丢失以及各个与大略几许猜测、不透明度猜测和可微分PNP丢失相关的丢失项。

■3.1 数据集

PL-LRM模型只需要多视图带有位姿图画来进行练习。为了构建一个大规模的多视图姿态数据集,研究人员运用了Objaverse 和MVImgNet的数据。为了评价模型的跨数据集泛化才能,研究人员运用一些数据集,包括OmniObject3D , Google Scanned Objects(GSO), Amazon Berkeley Objects(ABO), Common Objects 3D (CO3D),和DTU。

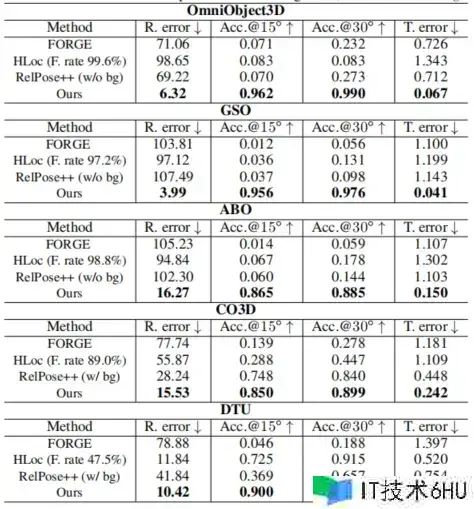

■3.2 baseline对比

研究人员在姿态估量和三维重建两个使命上根据基线评价其功能。对于姿态估量使命,将PF-LRM与FORGE、RelPose++和根据sfm的办法HLoc。研究人员还在重建质量方面与FORGE进行了比较。(一些办法由于缺少可用的开源代码,以及在研究范围内的有着显着差异,没有进行比较)

▲表1|各个数据集试验

■3.3 结果

本模型在OmniObjects3D、ABO、GSO、CO3D和DTU等不知道数据集上取得了超卓的成果。比较基线办法(FORGE、HLoc、RelPose++),本文的模型在各项度量指标下都取得了明显的优势。作者特别重视了不同办法在跨数据集泛化才能方面的体现,这反映了它们在实践使用中的功能。对于OmniObjects3D、GSO和ABO数据集,作者相对FORGE取得了均匀14.6倍的旋转差错减少率,相对HLoc和RelPose++分别为15.3倍和14.7倍。

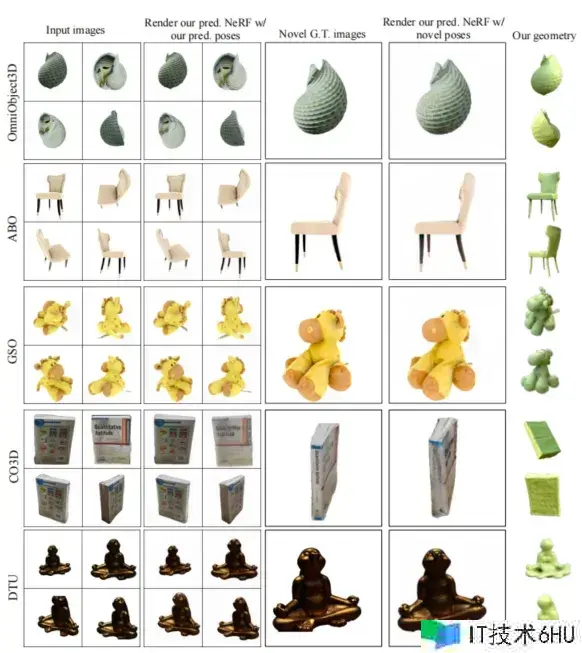

本模型在处理非信息性白色背景输入图画时体现超卓,比较较其他办法能够取得更准确的姿态估量结果。在CO3D和DTU数据集上,本模型也展示出了比RelPose++和FORGE更好的泛化才能。在重建质量方面,本文的模型在OmniObjects3D、GSO和ABO数据集上体现超卓,均匀PSNR为24.8,远远超越基线办法FORGE的13.4。

本模型能够产生高质量的重建,并且在烘托NeRF时能够与实践输入图画相匹配。比较之下,基线办法FORGE在这一方针上体现欠安,显示出PSNR较低的趋势。

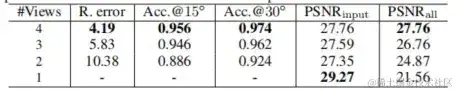

▲图3|各数据集生成试验

除此之外,经过对可变数量的输入视图进行测试,作者的模型展示了必定程度的鲁棒性,在减少视图数量的情况下功能有所下降,但降低的幅度是能够接受的。但是,当输入的分割掩模非常嘈杂时,模型功能显着下降,这与CO3D数据集提供的不准确掩模可能对模型功能造成负面影响共同。

▲表2|少视图输出试验

在这项作业中,研究人员提出了一个根据tansformer的三维重建大模型来估量摄像机参数,并以三平面NeRF来重建三维物体。该模型选用自注意力机制,以三平面token和图画patch token相互沟通关键信息,然后进步终究NeRF重建质量,并运用可微PnP求解器进行鲁棒的每个patch表面点猜测。现在该模型在姿态猜测精度和重建质量方面大大优于基线办法,也能够在下游使用程序中运用,比如文本/图画到3D生成。

虽然该模型的重建和姿态猜测功能非常强大,但在未来的作业中仍存在一些局限性:

1)首先,在猜测相机姿态时,忽略了可能包括丰厚线索的背景信息,如消失点、投射阴影等。假如将作业扩展到处理空间歪曲的背景将会很风趣。

2) PF-LRM猜测的三平面NeRF的分辨率也能够经过探究粗到细建模或其他高容量紧凑表明等技能,如多分辨率体素网格以完成更详细的几许和纹理重建。

3)该模型现在假设已知参数是来自相机传感器元数据,未来的作业也能够探究猜测相机扫描的技能。

4) 虽然该模型在测试期间是无姿态的,但它依然需要GT真实位姿监督来练习;一个风趣的方向是在练习进程中进步摄像机位姿的要求,以运用大量的野外直接拍摄的视频练习数据。

欢迎重视公众号CV技能攻略,专心于计算机视觉的技能总结、最新技能盯梢、经典论文解读、CV招聘信息。

【技能文档】《从零建立pytorch模型教程》122页PDF下载

QQ沟通群:470899183。群内有大佬负责回答我们的日常学习、科研、代码问题。

其它文章

LSKA注意力 | 重新思考和规划大卷积核注意力,功能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改善小型ViT

ICCV2023|涨点神器!方针检测蒸馏学习新办法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图画融合与分割研究:全时多模态基准与多交互特征学习

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 处理DeepSORT等盯梢办法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,功能直逼GPT-4

SAM-Med2D:打破天然图画与医学图画的领域距离,医疗版 SAM 开源了!

GhostSR|针对图画超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追寻模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,功能到达UNet家族的巅峰!