一、背景

最近智能客服产品给到一个游戏客户那边,客户那边的客服负责人体会后认为咱们产品回答的准确率是仍是比较高的。同时,他反应了几个需求改善的当地,其间一个便是机器人回复慢。机器人回复慢有很多原因,也有优化方式,其间一个便是流式呼应。

二、原理

咱们在微信需求发送比较长一段文字的时分,咱们需求花比较长的时刻去写,跟你聊天的人那边的感受便是要有一段时刻的等候。如果咱们每写好一句话就先发送过去,对方的等候的感觉就会弱一点。推到极致便是,咱们每写一个字就发送过去,这样对方的等候感是最弱的。当然,人不可能这么做 ,因为咱们要查看和改动咱们写的内容。可是LLM能够,因为LLM也是一个一个token生成,并且不需求查看和改动。

LLM运用要完成流式呼应,其实需求三个点都支撑流式呼应。

首要,LLM生成呼应的时分,每生成一部分要先提早回来。百度的ernie-bot-4 是支撑流式呼应的,只需求恳求body中带上参数 stream=True。

其次,运用服务器跟LLM服务器间的数据通道需求支撑流式呼应,一般http接口的封装都有这个参数,比如python request包的post办法的stream参数。

最终,运用服务器回来给前端的数据通道,以及前端展示要支撑流式呼应。gradio的chatbot也是支撑流式呼应的。

三、实践

万事俱备,就等coding。

LLM和数据通道这块都只是加个参数,这个改动不大。咱们来看下gradio的流式怎样完成。

如果咱们要用gradio完成一个回显的demo(便是咱们发送什么,服务器就回来什么),咱们会这么完成

import random

import gradio as gr

def echo_response(message, history):

return "你输入:" + message

gr.ChatInterface(echo_response).launch()

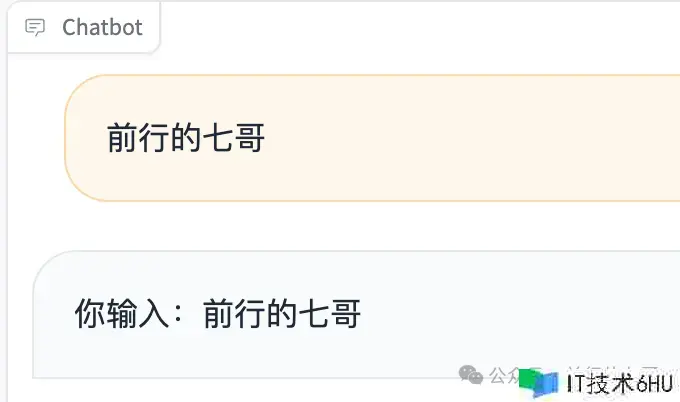

输出作用如下:

完成一个流式呼应的也很简单,差异便是把呼应函数变成一个生成器,每次回来最新的音讯:

import time

import gradio as gr

def echo_response(message, history):

for i in range(len(message)):

time.sleep(0.3)

yield "你输入: " + message[: i+1]

gr.ChatInterface(echo_response).launch()

为了看到回显音讯一个字一个字出来,成心每添加输出一个字推迟0.3秒。看的的作用便是“你输入:”后边的字一个一个显示出来。

接下来便是把LLM的流式呼应参数和http通道的流式呼应的参数设置为True,然后把gradio的呼应函数改成生成器即可。

运用百度 ernie-bot 和 gradio 写了个demo,把全流程串起来验证了下,log中能够看到ernie-bot的分批回来:

{'id': 'as-gxfvpsrx35', 'object': 'chat.completion', 'created': 1707351331, 'sentence_id': 0, 'is_end': False, 'is_truncated': False, 'result': '我是百度公司', 'need_clear_history': False, 'finish_reason': 'normal', 'usage': {'prompt_tokens': 2, 'completion_tokens': 0, 'total_tokens': 2}}

stream result:我是百度公司

{'id': 'as-gxfvpsrx35', 'object': 'chat.completion', 'created': 1707351334, 'sentence_id': 1, 'is_end': False, 'is_truncated': False, 'result': '开发的人工智能言语模型,我的中文名是文心一言,英文名是ERNIE Bot,我能够为人类供给信息解决问题,比如回答问题,供给界说、解说', 'need_clear_history': False, 'finish_reason': 'normal', 'usage': {'prompt_tokens': 2, 'completion_tokens': 0, 'total_tokens': 2}}

stream result:开发的人工智能言语模型,我的中文名是文心一言,英文名是ERNIE Bot,我能够为人类供给信息解决问题,比如回答问题,供给界说、解说

{'id': 'as-gxfvpsrx35', 'object': 'chat.completion', 'created': 1707351336, 'sentence_id': 2, 'is_end': False, 'is_truncated': False, 'result': '和主张,也能够辅助人类进行创造产生新的内容,如文本生成与创造、文本改写等。', 'need_clear_history': False, 'finish_reason': 'normal', 'usage': {'prompt_tokens': 2, 'completion_tokens': 0, 'total_tokens': 2}}

stream result:和主张,也能够辅助人类进行创造产生新的内容,如文本生成与创造、文本改写等。

{'id': 'as-gxfvpsrx35', 'object': 'chat.completion', 'created': 1707351337, 'sentence_id': 3, 'is_end': False, 'is_truncated': False, 'result': '如果您有任何问题,请随时向我发问。', 'need_clear_history': False, 'finish_reason': 'normal', 'usage': {'prompt_tokens': 2, 'completion_tokens': 0, 'total_tokens': 2}}

stream result:如果您有任何问题,请随时向我发问。

{'id': 'as-gxfvpsrx35', 'object': 'chat.completion', 'created': 1707351337, 'sentence_id': 4, 'is_end': True, 'is_truncated': False, 'result': '', 'need_clear_history': False, 'finish_reason': 'normal', 'usage': {'prompt_tokens': 2, 'completion_tokens': 62, 'total_tokens': 64}}

stream result:

文章的最终有demo代码,感兴趣的能够自己验证下。

四、感悟

demo好写,可是发现在智能机器人项目支撑这个仍是有点改动,从agent framework 到详细agent的完成,整个回来的线路都要改成生成器形式。

最近感悟便是,简单的RAG也好,让人惊喜的AGI也好,都十分容易完成,可是真正要落地到企业中,十分多的坑和需求探究解决的东西,无论是准确率、呼应速度、本钱,以及运用人的接受度等等。这也是很大一部分人时间短触摸LLM后抛弃的原因。

最近跟一些在做LLM运用的人聊,大家其实真的仍是需求信仰去支撑调prompt,去探究新的办法。毕竟,这真的是没有现成的技术计划能够参阅,就跟20年前怎样完成服务器高并发相同。那时分,C10K 问题都是会专门评论的(C10K problem: www.kegel.com/c10k.html )。 要做开拓者,先行者,这些都是必然会遇到的。

我正在开发一款根据自研的LLM agent framework 的智能客服产品,它具有私有知识问答,目的引导、信息收集、心情安抚、内部系统交融、LUI与GUI 交融、人工接收、数据剖析与洞察、异常监控等功能。

欢迎对prompt编写、LLM运用开发与落地、智能客服产品等等感兴趣的朋友加我微信,一同沟通,一起前行。

今天是2024年的除夕了,在这里顺祝大家新年快乐!2023年大环境欠好,很多人不容易,可是要信任这都是暂时的,只要坚持前行,总有希望!