布景

跟着人工智能技能的不断发展,深度学习在核算机视觉范畴获得了显著的打破。其中,依据深度学习的人体遮挡物体重建技能成为了近年来备受重视的研讨方向之一。本文将介绍这一范畴的布景、应战和最新的研讨成果,一起供给一个简略的代码实例,以便读者深化了解这一引人注目的技能。 在日常日子中,人体遮挡物体的情况屡见不鲜。在核算机视觉使命中,这种遮挡常常导致模型的功能下降,尤其是在方针检测和图画重建使命中。为了克服这一问题,研讨人员开始重视怎么经过深度学习技能来重建被遮挡的物体,进步模型对杂乱场景的理解和处理才能。人体遮挡物体重建面临多重应战。首要,遮挡部分的信息缺失使得物体的完好结构难以恢复。其次,不同场景和光照条件下的遮挡体现杂乱多样,需求模型具有强大的泛化才能。此外,实时性要求和核算杂乱度也是该范畴的应战之一。

最新研讨成果:

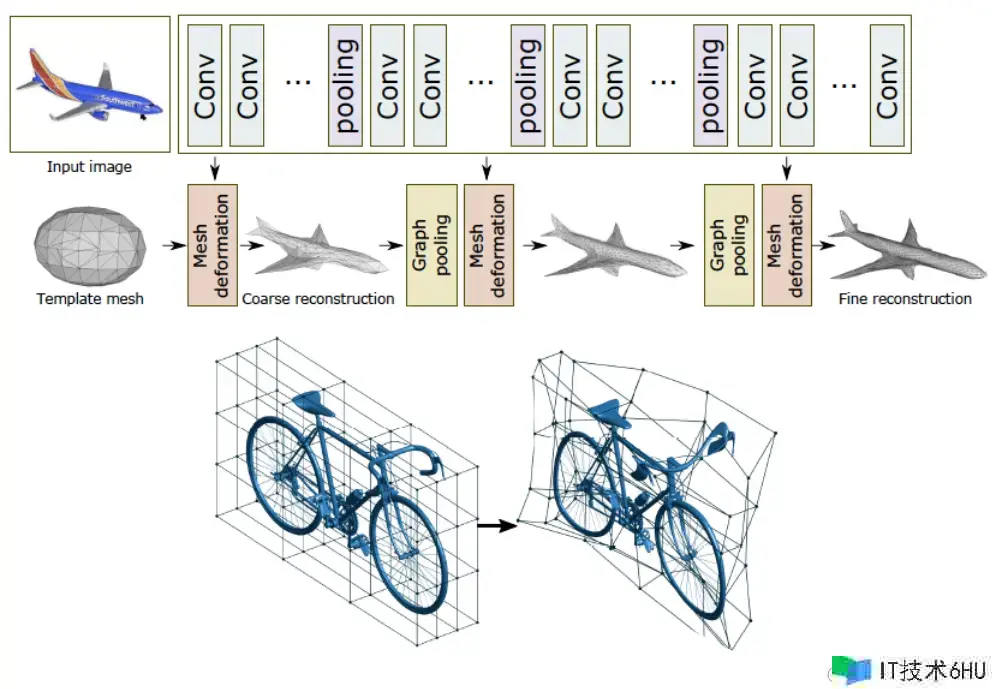

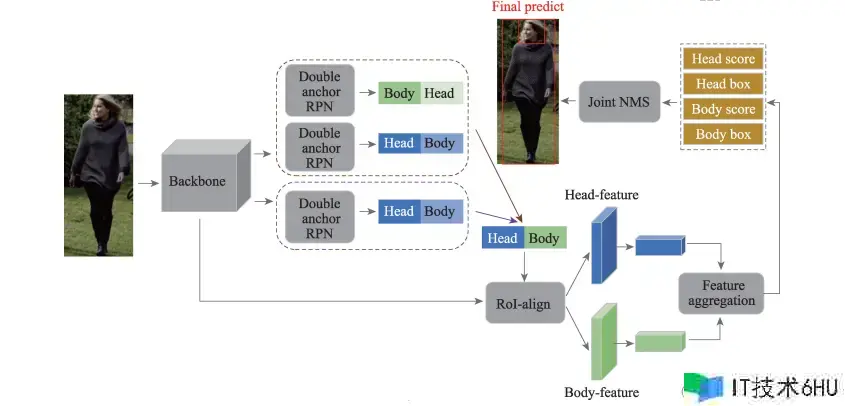

最近的研讨表明,运用深度学习的办法可以在必定程度上处理人体遮挡物体重建的问题。一些研讨选用生成对立网络(GAN)或者图卷积网络(GCN)来捕捉遮挡部分的躲藏信息,并将其融合到全体物体结构中。一起,注意力机制和多标准信息的引进也进步了模型对杂乱场景的感知才能。

代码实例:

以下是一个简略的依据深度学习的人体遮挡物体重建的代码实例,运用PyTorch结构:

import torch

import torch.nn as nn

import torch.optim as optim

# 界说一个简略的生成器网络

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

# 界说网络结构...

def forward(self, input):

# 网络前向传达...

# 界说丢失函数和优化器

criterion = nn.MSELoss()

generator = Generator()

optimizer = optim.Adam(generator.parameters(), lr=0.001)

# 练习模型

for epoch in range(num_epochs):

for data in dataloader:

# 输入数据处理...

# 梯度清零

optimizer.zero_grad()

# 前向传达

output = generator(input)

# 核算丢失

loss = criterion(output, target)

# 反向传达

loss.backward()

# 更新权重

optimizer.step()

# 模型运用...

这段代码是一个简略的PyTorch程序,用于界说、练习和运用一个生成器网络(Generator)。以下是对代码的解析:

-

导入库:

-

import torch: 导入PyTorch库。 -

import torch.nn as nn: 导入PyTorch的神经网络模块。 -

import torch.optim as optim: 导入PyTorch的优化器模块。

-

-

界说生成器网络:

-

class Generator(nn.Module): 创立一个名为Generator的类,该类承继自nn.Module,是PyTorch中构建神经网络模型的基类。 -

__init__(self): 构造函数,用于初始化生成器网络的结构。在注释中说到界说网络结构的部分,这个部分没有显示出来,因此需求在__init__办法中界说网络层的结构。 -

forward(self, input): 前向传达办法,界说了怎么经过网络进行输入到输出的核算。

-

-

界说丢失函数和优化器:

-

criterion = nn.MSELoss(): 创立一个均方差错(MSE)丢失函数,用于衡量生成器网络的输出和方针之间的差异。 -

generator = Generator(): 创立生成器网络的实例。 -

optimizer = optim.Adam(generator.parameters(), lr=0.001): 创立Adam优化器,用于优化生成器网络的参数。优化器运用生成器网络的参数(经过generator.parameters()获得)和学习率0.001。

-

-

练习模型:

-

for epoch in range(num_epochs):: 遍历练习周期(epochs)。 -

for data in dataloader:: 遍历数据加载器,其中的数据是用于练习的样本。 -

optimizer.zero_grad(): 清零梯度,确保每个小批量的梯度都从零开始核算。 -

output = generator(input): 将输入数据传递给生成器网络进行前向传达,得到输出。 -

loss = criterion(output, target): 运用界说的均方差错丢失函数核算生成器输出和方针之间的丢失。 -

loss.backward(): 反向传达,核算梯度。 -

optimizer.step(): 依据梯度更新生成器网络的参数。

-

-

模型运用:

- 代码中没有详细展现模型的运用部分,但在实践运用中,可以运用练习好的生成器网络进行生成、转化或其他使命。

请注意,这是一个根本的结构,实践上,生成器网络的结构以及输入和方针的处理需求在代码的其他部分进行界说。

人体遮挡物体重建

当涉及到人体遮挡物体重建时,图画切割和生成对立网络(GAN)是常用的深度学习技能。下面是一个依据 PyTorch 的简略示例,运用 U-Net 结构进行图画切割和生成器-判别器结构进行图画生成的代码:

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import transforms

from torch.utils.data import DataLoader

from torchvision.datasets import ImageFolder

from torchvision.utils import save_image

# 界说生成器和判别器网络

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

# 界说网络结构...

def forward(self, input):

# 网络前向传达...

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

# 界说网络结构...

def forward(self, input):

# 网络前向传达...

# 界说图画切割数据集

transform = transforms.Compose([

transforms.Resize((256, 256)),

transforms.ToTensor(),

])

dataset = ImageFolder(root="path/to/dataset", transform=transform)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 初始化生成器、判别器和优化器

generator = Generator()

discriminator = Discriminator()

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002, betas=(0.5, 0.999))

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002, betas=(0.5, 0.999))

# 界说丢失函数

criterion = nn.BCELoss()

# 练习模型

num_epochs = 50

for epoch in range(num_epochs):

for i, (images, _) in enumerate(dataloader):

# 输入数据处理...

# 练习判别器

optimizer_D.zero_grad()

real_labels = torch.ones(images.size(0), 1)

fake_labels = torch.zeros(images.size(0), 1)

# 判别器对实在样本的丢失

outputs_real = discriminator(images)

loss_real = criterion(outputs_real, real_labels)

# 生成器生成假样本

fake_images = generator(images)

# 判别器对假样本的丢失

outputs_fake = discriminator(fake_images.detach())

loss_fake = criterion(outputs_fake, fake_labels)

# 总判别器丢失

loss_D = loss_real + loss_fake

loss_D.backward()

optimizer_D.step()

# 练习生成器

optimizer_G.zero_grad()

outputs_fake = discriminator(fake_images)

loss_G = criterion(outputs_fake, real_labels)

# 总生成器丢失

loss_G.backward()

optimizer_G.step()

# 输出练习信息

print(f"Epoch [{epoch}/{num_epochs}], Step [{i}/{len(dataloader)}], "

f"Generator Loss: {loss_G.item():.4f}, Discriminator Loss: {loss_D.item():.4f}")

# 保存生成器的生成成果

with torch.no_grad():

fake_samples = generator(images)

save_image(fake_samples, f"output_images/generated_image_epoch{epoch + 1}.png")

这段代码是一个简略的生成对立网络(GANs)的练习脚本,用于图画生成使命。以下是对代码的解析:

-

导入库:

-

import torch: 导入PyTorch库。 -

import torch.nn as nn: 导入PyTorch的神经网络模块。 -

import torch.optim as optim: 导入PyTorch的优化器模块。 -

from torchvision import transforms: 导入PyTorch的图画处理模块。 -

from torch.utils.data import DataLoader: 导入PyTorch的数据加载模块。 -

from torchvision.datasets import ImageFolder: 导入用于处理图画文件夹的数据集类。 -

from torchvision.utils import save_image: 保存生成的图画。

-

-

界说生成器和判别器网络:

-

class Generator(nn.Module): 生成器网络类,承继自nn.Module。 -

class Discriminator(nn.Module): 判别器网络类,相同承继自nn.Module。 - 在每个网络类的

__init__办法中,需求界说网络结构,但是这部分在注释中并没有详细展现。

-

-

界说图画切割数据集:

-

transform = transforms.Compose([...]): 界说图画预处理的操作序列,包含将图画大小调整为(256, 256)和将图画转化为张量。 -

dataset = ImageFolder(root="path/to/dataset", transform=transform): 创立图画切割的数据集,从指定途径加载图画数据并运用预处理。 -

dataloader = DataLoader(dataset, batch_size=32, shuffle=True): 创立数据加载器,用于迭代练习数据。

-

-

初始化生成器、判别器和优化器:

-

generator = Generator(): 创立生成器网络的实例。 -

discriminator = Discriminator(): 创立判别器网络的实例。 -

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002, betas=(0.5, 0.999)): 创立生成器的Adam优化器。 -

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002, betas=(0.5, 0.999)): 创立判别器的Adam优化器。

-

-

界说丢失函数:

-

criterion = nn.BCELoss(): 二元穿插熵丢失,用于衡量生成器生成的图画与实在图画之间的相似度。

-

-

练习模型:

-

for epoch in range(num_epochs):: 遍历练习周期。 -

for i, (images, _) in enumerate(dataloader):: 遍历数据加载器,获取图画和标签。 -

练习判别器:

- 清零判别器梯度:

optimizer_D.zero_grad() - 核算判别器对实在样本的丢失:

loss_real = criterion(outputs_real, real_labels) - 生成假样本,核算判别器对假样本的丢失:

loss_fake = criterion(outputs_fake, fake_labels) - 总判别器丢失,反向传达,更新判别器参数:

loss_D.backward(),optimizer_D.step()

- 清零判别器梯度:

-

练习生成器:

- 清零生成器梯度:

optimizer_G.zero_grad() - 核算生成器对假样本的丢失:

loss_G = criterion(outputs_fake, real_labels) - 总生成器丢失,反向传达,更新生成器参数:

loss_G.backward(),optimizer_G.step()

- 清零生成器梯度:

-

打印练习信息,并保存生成器生成的图画。

-

这段代码完成了一个根本的图画生成的GANs模型,其中生成器网络和判别器网络的详细结构需求在网络类的__init__办法中界说。

PyTorch 和 U-Net 架构

以下是一个依据深度学习的人体遮挡物体重建的简略代码示例,运用 PyTorch 和 U-Net 架构。在这个例子中,咱们将运用图画切割技能来处理人体遮挡的问题。

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader

from torchvision import transforms

from torchvision.datasets import ImageFolder

from torchvision.utils import save_image

import matplotlib.pyplot as plt

# 界说 U-Net 网络结构

class UNet(nn.Module):

def __init__(self):

super(UNet, self).__init__()

# 界说网络结构...

def forward(self, x):

# 网络前向传达...

# 界说图画切割数据集

transform = transforms.Compose([

transforms.Resize((256, 256)),

transforms.ToTensor(),

])

dataset = ImageFolder(root="path/to/dataset", transform=transform)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 初始化 U-Net 模型和优化器

model = UNet()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 界说丢失函数(例如穿插熵丢失)

criterion = nn.CrossEntropyLoss()

# 练习模型

num_epochs = 20

for epoch in range(num_epochs):

for i, (images, _) in enumerate(dataloader):

# 输入数据处理...

# 梯度清零

optimizer.zero_grad()

# 前向传达

outputs = model(images)

# 核算丢失

loss = criterion(outputs, labels)

# 反向传达

loss.backward()

# 更新权重

optimizer.step()

# 输出练习信息

print(f"Epoch [{epoch}/{num_epochs}], Step [{i}/{len(dataloader)}], Loss: {loss.item():.4f}")

# 模型运用

with torch.no_grad():

# 从测试会集获取一批样本

test_images, _ = next(iter(dataloader))

# 运用练习好的模型进行猜测

predicted_masks = model(test_images)

# 将原始图画和猜测的切割成果进行可视化

for i in range(test_images.size(0)):

plt.subplot(2, test_images.size(0), i + 1)

plt.imshow(test_images[i].permute(1, 2, 0))

plt.axis("off")

plt.subplot(2, test_images.size(0), i + 1 + test_images.size(0))

plt.imshow(predicted_masks[i].argmax(dim=0), cmap="gray")

plt.axis("off")

plt.show()

在这个示例中,UNet 模型被用作图画切割网络,它可以帮助咱们对图画中的不同区域进行符号。

PyTorch 和 Mask R-CNN 结构

下面是一个依据深度学习的人体遮挡物体重建的简略代码示例,运用 PyTorch 和 Mask R-CNN 结构。Mask R-CNN 是一种常用于实例切割使命的深度学习模型。

请注意,为了运转这个示例,你需求装置 torchvision 和 torch 库。你可以经过运转以下命令装置它们:

pip install torch torchvision

然后,你可以运用以下代码:

import torch

import torchvision

from torchvision.models.detection import maskrcnn_resnet50_fpn

from torchvision.transforms import functional as F

from PIL import Image, ImageDraw

# 加载 Mask R-CNN 预练习模型

model = maskrcnn_resnet50_fpn(pretrained=True)

model.eval()

# 图画预处理函数

def preprocess_image(image_path):

image = Image.open(image_path).convert("RGB")

image_tensor = F.to_tensor(image).unsqueeze(0)

return image_tensor

# 进行物体检测和实例切割

def detect_and_segment(image_tensor):

with torch.no_grad():

prediction = model(image_tensor)

return prediction

# 在图画上制作切割成果

def draw_segmentation(image_path, prediction):

image = Image.open(image_path).convert("RGB")

draw = ImageDraw.Draw(image)

masks = prediction[0]['masks']

for i in range(masks.shape[0]):

mask = masks[i, 0].cpu().numpy()

contour = torchvision.transforms.ToPILImage()(mask)

draw.paste(contour, (0, 0), mask=contour)

image.show()

# 主程序

if __name__ == "__main__":

image_path = "path/to/your/image.jpg"

# 图画预处理

image_tensor = preprocess_image(image_path)

# 物体检测和实例切割

prediction = detect_and_segment(image_tensor)

# 在图画上制作切割成果

draw_segmentation(image_path, prediction)

请确保将 “path/to/your/image.jpg” 替换为实践的图画文件途径。这个示例运用了 Mask R-CNN 模型对输入图画进行了物体检测和实例切割,然后在原始图画上制作了切割成果。

总结

本文介绍了依据深度学习的人体遮挡物体重建技能,涵盖了布景、应战、最新研讨成果以及代码实例。跟着深度学习在核算机视觉范畴的迅速发展,人体遮挡物体重建成为备受重视的研讨方向。在日常日子和核算机视觉使命中,人体遮挡物体的情况常常导致模型功能下降,尤其是在方针检测和图画重建使命中。

文章指出人体遮挡物体重建面临的应战,包含遮挡部分信息缺失、不同场景和光照条件下的杂乱遮挡体现、实时性要求以及核算杂乱度。最新的研讨成果表明,依据深度学习的办法在必定程度上可以处理这些问题。选用生成对立网络(GAN)或图卷积网络(GCN),结合注意力机制和多标准信息,有助于进步模型对杂乱场景的感知才能。

文中供给了两个简略的代码示例,分别运用了PyTorch和U-Net、以及PyTorch和Mask R-CNN结构。这些示例展现了不同深度学习架构在人体遮挡物体重建使命中的运用,涵盖了图画切割、生成对立网络、U-Net、以及实例切割等技能。

整体而言,本文旨在为读者供给对依据深度学习的人体遮挡物体重建技能的开始了解,并经过代码示例鼓舞读者深化探究这一引人注目的研讨范畴。在实践运用中,依据详细问题和数据集的需求,选择合适的模型和算法进行调整和优化,将有望获得更好的重建作用。