论文介绍 FreeControl: 无需额定练习完成文本到图画的空间操控!

论文介绍 FreeControl: Training-Free Spatial Control of Any Text-to-Image Diffusion Model with Any Condition

重视微信大众号: DeepGo

项目地址:genforce.github.io/freecontrol…

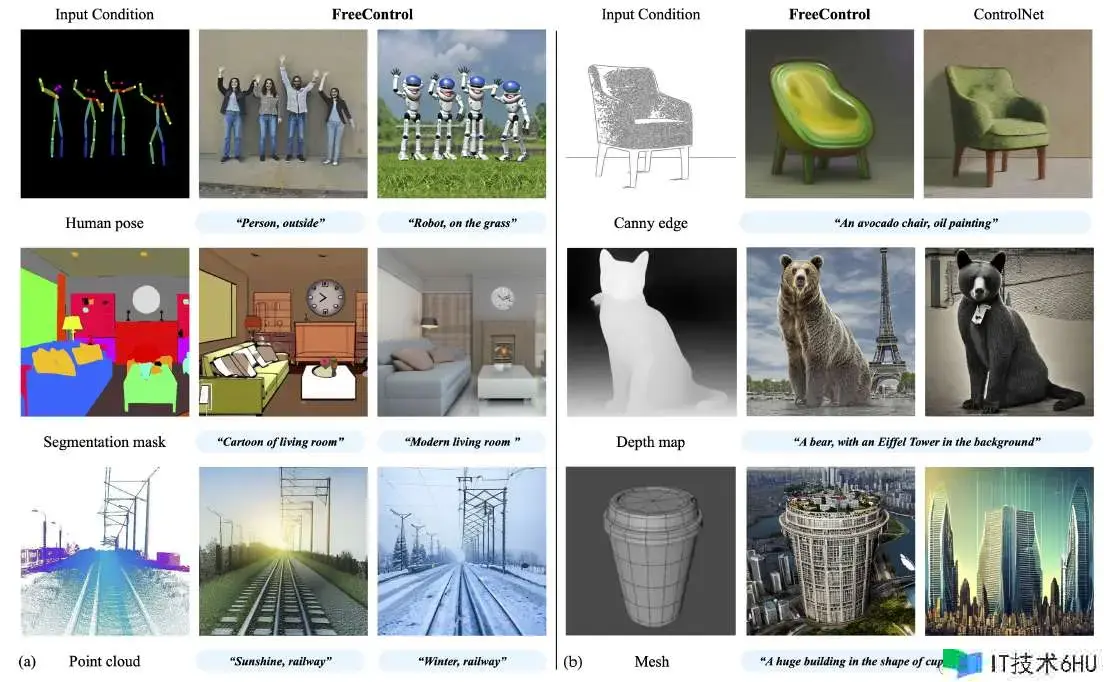

本文介绍一种新颖的图画编辑算法FreeControl,答应用户在不需求额定练习的情况下,对预练习的文本到图画(T2I)分散模型进行空间操控。它经过剖析和组成两个阶段作业,首先从方针概念生成种子图画,并对它们的分散特征进行主成分剖析(PCA)以取得线性质空间作为语义根底。然后,在组成阶段,运用结构引导和外观引导来保证生成的图画在结构上与指导图画共同,一起在外观上与同一种子未进行结构操控生成的图画类似。

问题、挑战和奉献

该论文测验处理的首要问题和挑战是怎么在不需求额定练习的情况下,为预练习的文本到图画(T2I)分散模型供给精密的空间操控。现有的办法,如ControlNet,尽管可以供给空间操控,但需求为每种空间条件、模型架构和模型文件练习额定的模块,这既耗时又吃力,且难以适应不断演化的模型架构和个性化的模型。此外,这些办法面临高练习本钱、可扩展性差和由练习方案导致的约束,如操控信号难以从图画中推断、模型倾向于优先考虑空间条件而非文本描绘等问题。

办法概述

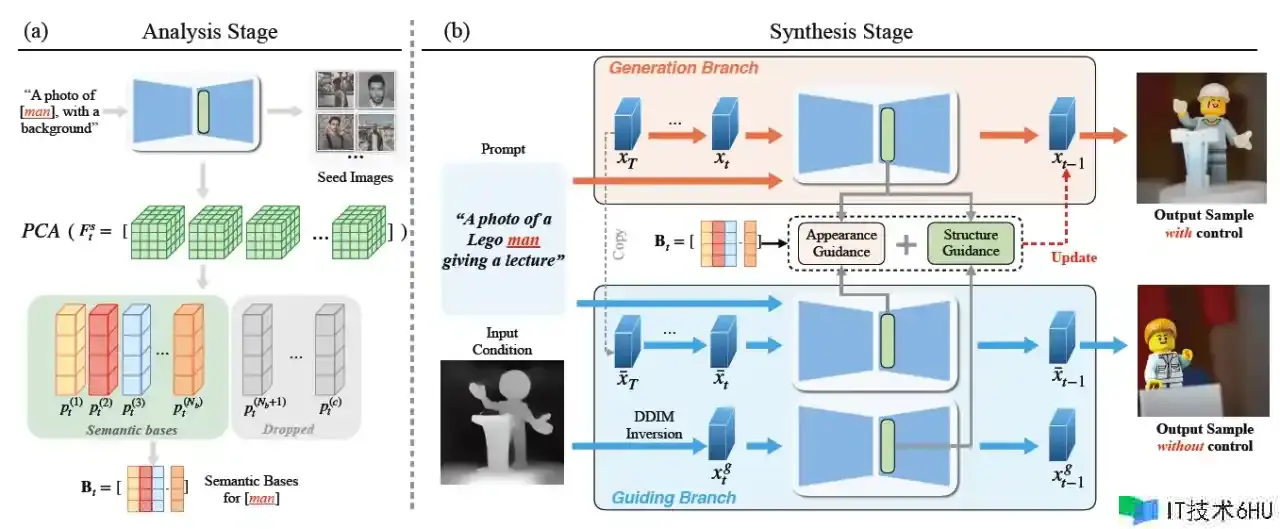

FreeControl 分为两个阶段:剖析阶段和组成阶段。

- 剖析阶段:经过对种子图画的分散特征进行主成分剖析(PCA),构成时刻依靠的基BtB_t,作为语义结构表明。

- 组成阶段:结构引导帮助在引导图画IgI_g的指导下构建输出图画II的结构模板,而外观引导从相同种子生成的兄弟图画Ibar{I}中借用外观细节。

语义结构表明

在完成文本到图画(T2I)分散的零样本空间操控时,关键在于需求一种对图画模态不变的语义图画结构的统一表明。根据最近的研究,自监督的 Vision Transformers 和 T2I 分散模型中的自留意力特征(即键和查询)被认为是图画结构的强壮描绘符。因此,作者假设操纵这些自留意力特征是完成可控 T2I 分散的关键。

-

直接注入办法的局限性: 在 Plug-and-Play(PnP)办法中,测验直接将引导图画(IgI_g)的自留意力权重(或等效的特征)注入到图画 II 的分散进程中。这种办法容易引入外观走漏,即不仅传递了 IgI_g 的结构,还传递了外观细节的痕迹,特别是当 IgI_g 和 II 属于不同模态时(例如,深度图与天然图画),这在可控生成中是一个问题。

-

图画结构与外观的分离: 为了分离图画的结构和外观,作者借鉴了 Transformer 特征可视化的办法,对一组语义类似图画的自留意力特征履行主成分剖析(PCA)。作者的关键观察是,首要的 PCs 构成了一个语义根底;它与不同图画模态中的方针姿势、形状和场景构成表现出激烈的相关性。作者利用这个根底作为语义结构表明,并在剖析阶段取得这些根底。

-

语义根底的获取: 首先收集一组 NsN_s 张图画 {Is}{I_s},这些图画与文本提示 cc 共享方针概念,运用经文本提示 c~tilde{c} 修改后的 epsilon_theta 生成,c~tilde{c} 将概念符号刺进到故意坚持通用的模板中(例如,“一张带布景的[]照片。”)。这使得 {Is}{I_s} 覆盖了多样的方针形状、姿势、外观以及图画构成和风格,对于语义根底的表达性至关重要。 经过对 {Is}{I_s} 履行 DDIM 逆向,以取得大小为 NsCHWN_s times C times H times W 的时刻依靠分散特征 {Fts}{F_{t}^s},发生 NsHWN_s times H times W 个不同的特征向量,对其履行 PCA 以取得时刻依靠的语义根底 BtB_t 作为前 NbN_b 个主成分:

Bt=[pt(1),pt(2),…,pt(Nb)]∼PCA({Fts})B_t = [p^{(1)}_t, p^{(2)}_t, ldots, p^{(N_b)}_t] sim PCA({F_{t}^s})直观地讲,BtB_t 跨越了不同图画模态的语义空间 StS_t,答应在组成阶段将图画结构从 IgI_g 传播到 II。 一旦核算出来,BtB_t 可以被相同的文本提示重复运用,或由具有相关概念的提示共享。因此,根底构建的本钱可以在组成阶段的屡次运行中分摊。

生成阶段

组成阶段经过引导将生成的图画II与引导图画IgI_g进行条件化。首先,作者用语义根底BtB_t表达IgI_g的语义结构。(ps: 原文的公式不知为何都在表达的时分,将大写字母成了小写,如M写成m,留意区分)

-

引导图画的逆变换:

作者对IgI_g履行DDIM逆变换,以获取尺寸为CHWC times H times W的分散特征FtgF_{t}^g,并将其投影到BtB_t上,得到其语义坐标StgS_{t}^g,尺寸为NbHWN_b times H times W。为了局部操控远景结构,作者进一步从概念符号的交叉留意力求中派生出掩码MM(尺寸HWH times W),大局操控时MM设置为1(尺寸HWH times W)。接下来介绍怎么运用结构引导来生成具有操控结构的II。

-

结构引导: 在每个去噪进程tt,作者经过将分散特征FtF_t从epsilon_theta投影到BtB_t上,取得语义坐标StS_t。结构引导的能量函数gsg_s可以表达为:

gs(St;Stg,M)=∑i,jmij∥[st]ij−[stg]ij∥22∑i,jmij+w⋅∑i,j(1−mij)∥max([st]ij−t,0)∥22∑i,j(1−mij) g_s(S_t; S_{t}^g, M) = frac{sum_{i,j} m_{ij} left| [s_t]_{ij} – [s_{t}^{g}]_{ij} right|^2_2}{sum_{i,j} m_{ij}} + w cdot frac{sum_{i,j} (1 – m_{ij}) left| max([s_t]_{ij} – tau_t, 0) right|^2_2}{sum_{i,j} (1 – m_{ij})}其间,ii和jj是StS_t、StgS_{t}^g和MM的空间索引,ww是平衡权重。阈值ttau_t界说为:

t=maxijs.t.mij=0[sgt]ijtau_t = max_{ij text{ s.t. } m_{ij} = 0} [s_{gt}]_{ij}直观来说,[st]ij>t[s_t]_{ij} > tau_t表明远景结构的存在。直观上,前向项引导II的结构与IgI_g在远景中对齐,而当M≠1M neq 1时,后向项经过按捺布景中的假结构来帮助雕刻出远景。

-

外观引导: 受DSG启发,作者将图画外观表明为{vt(k)}k=1Na≤Nb{v_t^{(k)}}_{k=1}^{N_a leq N_b},即分散特征FtF_t的加权空间均值:

vt(k)=∑i,j([st(k)]ij)[ft]ij∑i,j([st(k)]ij)v_t^{(k)} = frac{sum_{i,j} sigma([s_t^{(k)}]_{ij}) [f_t]_{ij}}{sum_{i,j} sigma([s_t^{(k)}]_{ij})}其间,ii和jj是StS_t和FtF_t的空间索引,kk是[st]ij[s_t]_{ij}的通道索引,sigma是Sigmoid函数。作者将StS_t用作权重,以便不同的vt(k)v_t^{(k)}编码不同语义组件的外观。对于II和Ibar{I},作者在每个时刻进程tt分别核算{vt(k)}{v_t^{(k)}}和{vt(k)}{bar{v}_t^{(k)}}。 外观引导的能量函数gag_a可以表达为:

ga({vt(k)};{v~t(k)})=∑k=1Na∥vt(k)−v~t(k)∥2Na,g_aleft(left{v_t^{(k)}right}; left{tilde{v}_t^{(k)}right}right) = frac{sum_{k=1}^{N_a} left| v_t^{(k)} – tilde{v}_t^{(k)} right|^2}{N_a},它惩罚外观表明之间的差异,从而促进从Ibar{I}到II的外观转移。 (DSG: Diffusion self-guidance for controllable image generation)

-

引导生成进程: 最后,作者经过结构和外观引导以及无分类器引导,得到修改后的分数估计that{epsilon}_t:

t=(1+s)(xt;t,c)−s(xt;t,∅)+sgs+agahat{epsilon}_t = (1+s) epsilon_theta(x_t; t, c) – s epsilon_theta(x_t; t, emptyset) + lambda_s g_s + lambda_a g_a其间,ss、slambda_s和alambda_a是各自引导的强度。

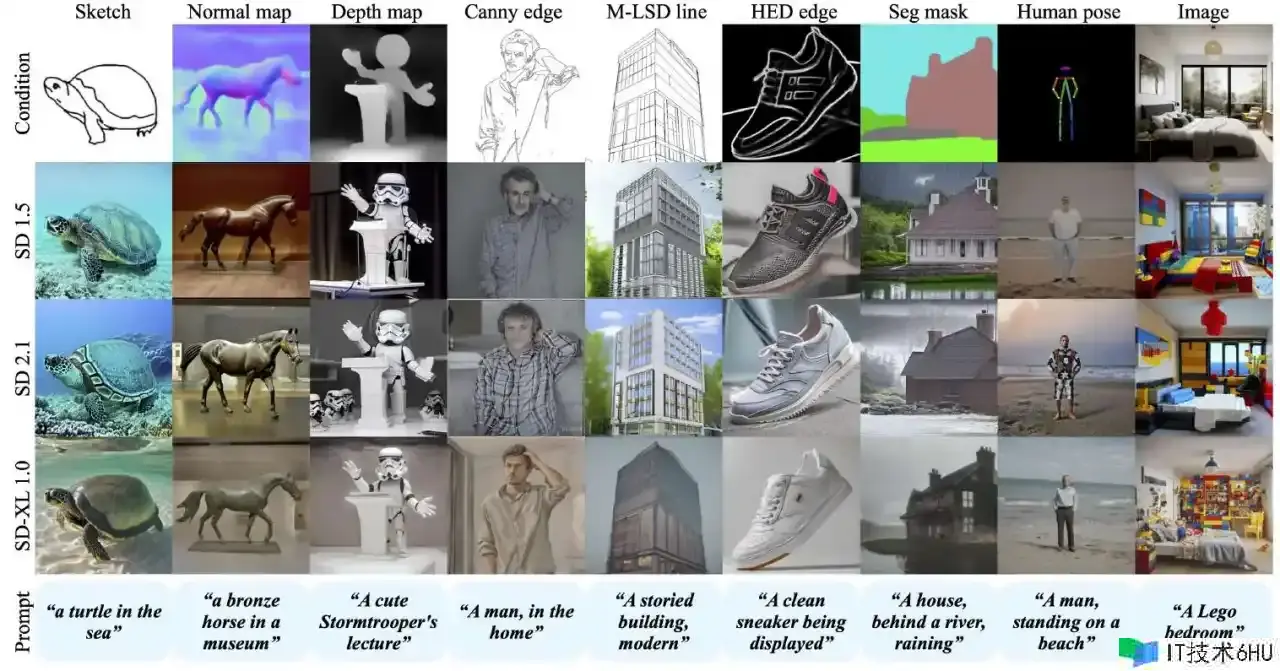

试验结果

总结

FreeControl支持多种操控条件、模型架构和自界说模型文件,可以处理大多数现有无练习办法失利的挑战性输入条件,并且与根据练习的办法比较,完成了竞争性的组成质量。经过在多个预练习的T2I模型上的广泛定性和定量试验,FreeControl展现了其优胜的功能。 尽管它依靠于DDIM反转进程来提取指导图画的中间特征和核算组成阶段的额定梯度,这导致了推理时刻的添加。希望这项作业能为可控的视觉内容创造供给新的见解和剖析。

更多细节请参阅论文原文