导言:

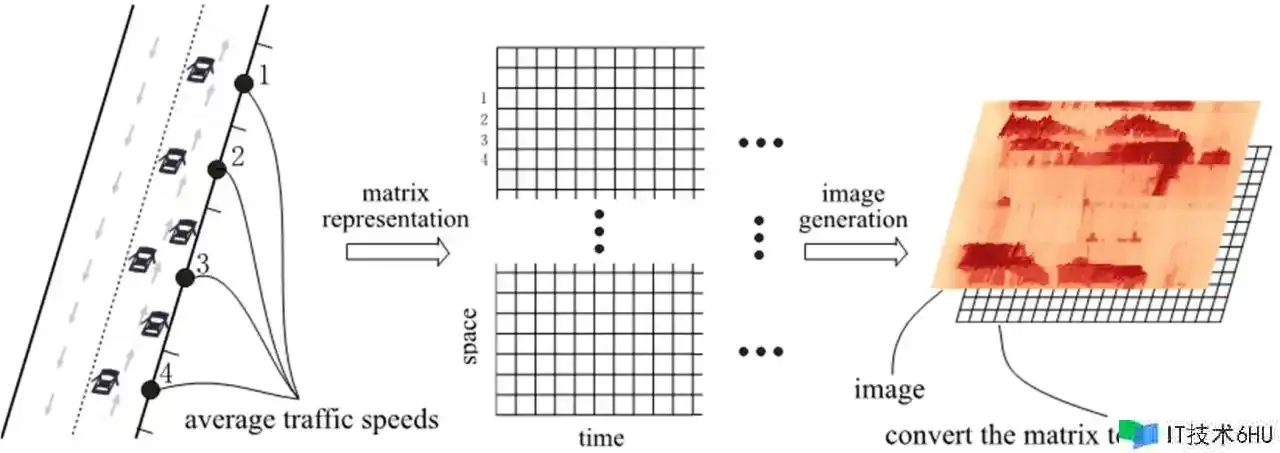

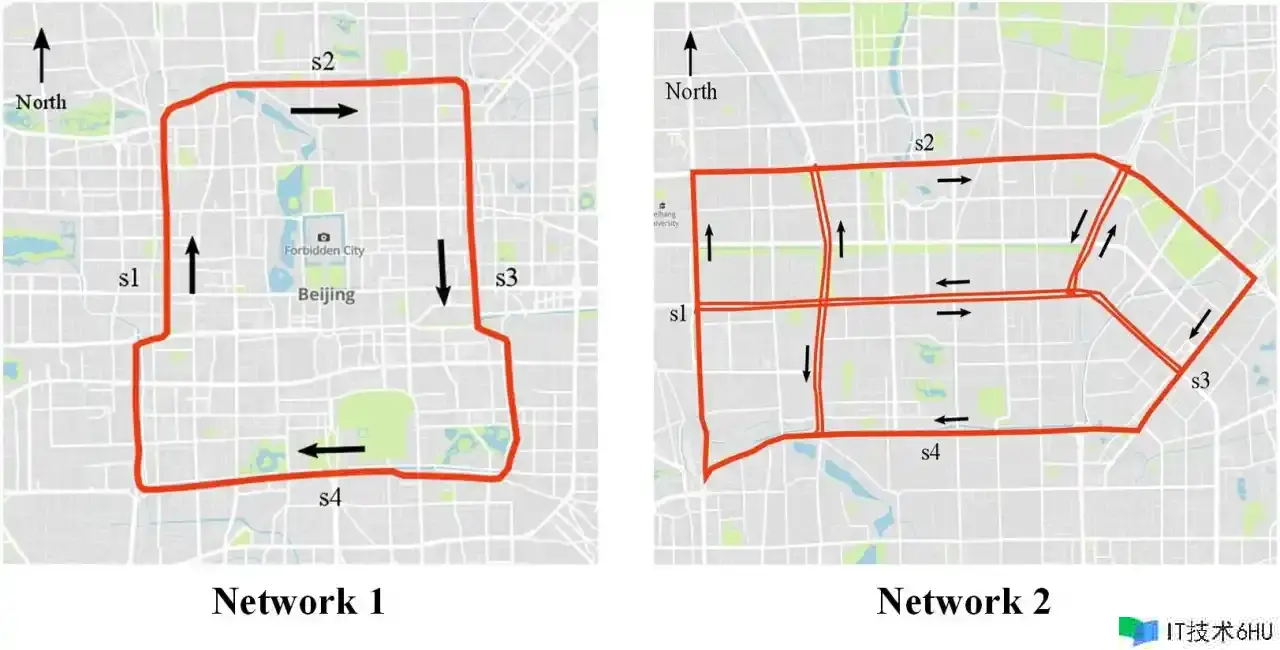

跟着城市化进程的不断推进,交通拥堵成为城市面临的一项严峻应战。人工智能技能的快速发展为处理交通拥堵问题供给了新的或许性。本文将介绍一种根据卷积神经网络(CNN)的交通拥堵猜测办法,并供给相应的代码实例,展现其在实践运用中的潜力。 交通拥堵对城市居民和经济活动带来了严峻的影响。为了更有效地管理城市交通,提前猜测拥堵情况成为一项要害使命。卷积神经网络是一种强大的深度学习模型,经过其在图像识别等范畴的成功运用,咱们能够将其运用于交通拥堵猜测中。

数据搜集与预备:

首先,咱们需要搜集城市交通数据,包含车辆流量、路途情况、气候等信息。这些数据能够来自交通监控摄像头、GPS设备、气候站等。在搜集到满足的数据后,咱们将其进行预处理,包含数据清洗、规范化等过程,以便用于练习咱们的卷积神经网络模型。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 读取原始数据

traffic_data = pd.read_csv('traffic_data.csv')

# 数据清洗

traffic_data = traffic_data.dropna()

# 特征挑选

features = traffic_data[['vehicle_flow', 'road_condition', 'weather']]

# 标签

labels = traffic_data['congestion_level']

# 数据规范化

scaler = StandardScaler()

features_scaled = scaler.fit_transform(features)

# 区分练习集和测验集

X_train, X_test, y_train, y_test = train_test_split(features_scaled, labels, test_size=0.2, random_state=42)

-

导入库:

- 导入

pandas用于数据处理和剖析。 - 导入

train_test_split用于将数据集区分为练习集和测验集。 - 导入

StandardScaler用于对数据进行规范化。

- 导入

-

读取数据:

- 从名为 ‘traffic_data.csv’ 的 CSV 文件中读取交通数据,并将其存储在一个名为

traffic_data的数据框中。

- 从名为 ‘traffic_data.csv’ 的 CSV 文件中读取交通数据,并将其存储在一个名为

-

数据清洗:

- 删除包含缺失值的行,保证数据集中没有缺失数据。

-

特征挑选:

- 从数据中挑选三个特征:’vehicle_flow’(车辆流量),’road_condition’(路途情况),’weather’(气候)。

-

标签挑选:

- 挑选目标变量或标签,即 ‘congestion_level’(拥堵等级)。

-

数据规范化:

- 运用

StandardScaler对选定的特征进行规范化。规范化保证不同特征具有相同的规范,有助于练习机器学习模型。

- 运用

-

区分练习集和测验集:

- 将数据集区分为练习集和测验集。测验集占总数据的20%,并运用

random_state=42以保证区分是可重复的。终究,得到练习集的特征 (X_train)、测验集的特征 (X_test)、练习集的标签 (y_train) 和测验集的标签 (y_test)。这是为了在机器学习模型练习和评价过程中运用不同的数据集。

- 将数据集区分为练习集和测验集。测验集占总数据的20%,并运用

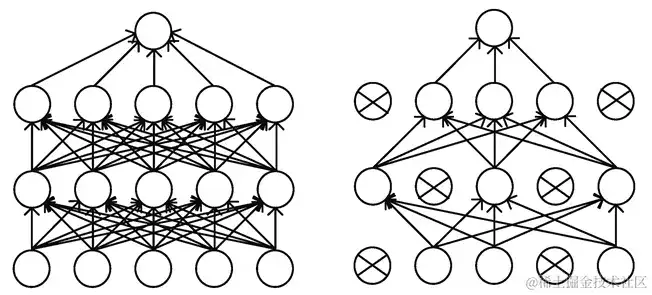

卷积神经网络模型:

构建交通拥堵猜测的卷积神经网络模型,其间包含卷积层、池化层和全衔接层。经过对前史交通数据的学习,模型能够捕捉不同要素对交通拥堵的影响。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv1D, MaxPooling1D, Flatten, Dense

model = Sequential()

model.add(Conv1D(filters=64, kernel_size=3, activation='relu', input_shape=(X_train.shape[1], 1)))

model.add(MaxPooling1D(pool_size=2))

model.add(Flatten())

model.add(Dense(50, activation='relu'))

model.add(Dense(1, activation='linear'))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 模型练习

model.fit(X_train.reshape(X_train.shape[0], X_train.shape[1], 1), y_train, epochs=10, batch_size=32, validation_data=(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test))

- 模型评价与猜测: 练习完成后,咱们能够运用测验集进行模型评价,并运用模型进行实时交通拥堵猜测。

# 代码示例:模型评价与猜测

from sklearn.metrics import mean_squared_error

# 模型评价

y_pred = model.predict(X_test.reshape(X_test.shape[0], X_test.shape[1], 1))

mse = mean_squared_error(y_test, y_pred)

print(f'Mean Squared Error: {mse}')

# 实时猜测

real_time_data = scaler.transform([[new_vehicle_flow, new_road_condition, new_weather]])

predicted_congestion_level = model.predict(real_time_data.reshape(1, real_time_data.shape[1], 1))

print(f'Predicted Congestion Level: {predicted_congestion_level[0][0]}')

-

导入库:

from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Conv1D, MaxPooling1D, Flatten, Dense- 导入 Keras 库中的相关模块,用于构建神经网络模型。

-

创立 Sequential 模型:

model = Sequential()- 创立一个序列型的神经网络模型。

-

增加卷积层:

model.add(Conv1D(filters=64, kernel_size=3, activation='relu', input_shape=(X_train.shape[1], 1)))- 增加一个卷积层,其间包含 64 个滤波器、卷积核大小为 3、激活函数为 ReLU,输入形状为

(X_train.shape[1], 1)。

- 增加一个卷积层,其间包含 64 个滤波器、卷积核大小为 3、激活函数为 ReLU,输入形状为

-

增加最大池化层:

model.add(MaxPooling1D(pool_size=2))- 增加一个最大池化层,用于下降特征图的空间维度,选用最大池化。

-

增加展平层:

model.add(Flatten())- 增加一个展平层,将卷积层和池化层输出的多维数据转换为一维。

-

增加全衔接层:

model.add(Dense(50, activation='relu'))- 增加一个包含 50 个神经元的全衔接层,运用 ReLU 作为激活函数。

-

增加输出层:

model.add(Dense(1, activation='linear'))- 增加一个包含 1 个神经元的输出层,运用线性激活函数。

-

编译模型:

model.compile(optimizer='adam', loss='mean_squared_error')- 编译模型,指定优化器为 Adam,损失函数为均方差错(mean squared error)。

-

模型练习:

model.fit(X_train.reshape(X_train.shape[0], X_train.shape[1], 1), y_train, epochs=10, batch_size=32, validation_data=(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test))- 运用练习数据进行模型练习,指定练习周期(epochs)为 10,批量大小为 32。一起,经过

validation_data参数指定测验集用于验证模型功能。注意在输入数据的维度上进行了 reshape 操作,以契合卷积层的输入要求。

- 运用练习数据进行模型练习,指定练习周期(epochs)为 10,批量大小为 32。一起,经过

卷积神经网络(CNN)

用于交通拥堵猜测

# 导入必要的库

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv1D, MaxPooling1D, Flatten, Dense

# 生成示例数据

np.random.seed(42)

num_samples = 1000

vehicle_flow = np.random.randint(50, 300, num_samples)

road_condition = np.random.uniform(0, 1, num_samples)

weather = np.random.uniform(0, 1, num_samples)

congestion_level = np.random.uniform(0, 1, num_samples)

# 创立数据框

data = pd.DataFrame({'vehicle_flow': vehicle_flow, 'road_condition': road_condition, 'weather': weather, 'congestion_level': congestion_level})

# 数据预处理

features = data[['vehicle_flow', 'road_condition', 'weather']]

labels = data['congestion_level']

scaler = StandardScaler()

features_scaled = scaler.fit_transform(features)

X_train, X_test, y_train, y_test = train_test_split(features_scaled, labels, test_size=0.2, random_state=42)

# 构建卷积神经网络模型

model = Sequential()

model.add(Conv1D(filters=64, kernel_size=3, activation='relu', input_shape=(X_train.shape[1], 1)))

model.add(MaxPooling1D(pool_size=2))

model.add(Flatten())

model.add(Dense(50, activation='relu'))

model.add(Dense(1, activation='linear'))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 模型练习

model.fit(X_train.reshape(X_train.shape[0], X_train.shape[1], 1), y_train, epochs=10, batch_size=32, validation_data=(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test))

# 模型评价

mse = model.evaluate(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test)

print(f'Mean Squared Error on Test Data: {mse}')

# 实时猜测

new_data = np.array([[200, 0.8, 0.3]]) # 请替换为实践的新数据

new_data_scaled = scaler.transform(new_data)

predicted_congestion_level = model.predict(new_data_scaled.reshape(1, new_data_scaled.shape[1], 1))

print(f'Predicted Congestion Level for New Data: {predicted_congestion_level[0][0]}')

- 明晰的模块化结构:代码以明晰的模块化结构组织,将不同的使命分为导入库、生成示例数据、数据预处理、模型构建、模型编译、模型练习、模型评价和实时猜测等部分。这使得代码易于理解和保护。

- 运用规范库:代码运用了许多常见的数据科学和机器学习库,如 NumPy、Pandas、Scikit-Learn 和 TensorFlow。这有助于进步代码的可读性和可保护性,并使其易于被其他人理解和运用。

-

随机数种子设置:经过运用

np.random.seed(42)设置随机数种子,保证了代码的可重复性。这在机器学习中是很重要的,尤其是在数据区分和模型练习中。 - 示例数据生成:运用随机生成的示例数据,使得代码能够独立运转和测验,而不依赖外部数据文件。这关于共享和复现代码很有协助。

- 数据预处理:进行了数据预处理过程,包含特征规范化和练习集、测验集的区分。这有助于进步模型的练习效果。

- 运用卷积神经网络模型:代码运用了卷积神经网络 (CNN) 模型,这关于处理时序数据(一维数据)能够供给必定的优势。模型结构明晰,包含卷积层、池化层、展平层和全衔接层。

- 模型评价和实时猜测:对模型进行了评价,运用均方差错(Mean Squared Error)作为损失函数,并输出了测验数据上的均方差错。一起,展现了怎么运用练习好的模型进行实时猜测,这关于模型在实践运用中的运用是非常有协助的。

- 注释:代码中包含了一些注释,解说了每个部分的功能和效果,进步了代码的可读性。

引入Dropout层以削减过拟合的危险

当涉及到实践运用时,咱们能够运用更加杂乱的模型和更多的数据来进步猜测功能。下面是一个运用更深层的卷积神经网络(CNN)结构的代码示例,一起加入了更多的数据预处理过程。

# 导入必要的库

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv1D, MaxPooling1D, Flatten, Dense, Dropout

# 生成示例数据

np.random.seed(42)

num_samples = 1000

vehicle_flow = np.random.randint(50, 300, num_samples)

road_condition = np.random.uniform(0, 1, num_samples)

weather = np.random.uniform(0, 1, num_samples)

congestion_level = np.random.uniform(0, 1, num_samples)

# 创立数据框

data = pd.DataFrame({'vehicle_flow': vehicle_flow, 'road_condition': road_condition, 'weather': weather, 'congestion_level': congestion_level})

# 数据预处理

features = data[['vehicle_flow', 'road_condition', 'weather']]

labels = data['congestion_level']

scaler = StandardScaler()

features_scaled = scaler.fit_transform(features)

X_train, X_test, y_train, y_test = train_test_split(features_scaled, labels, test_size=0.2, random_state=42)

# 构建深层卷积神经网络模型

model = Sequential()

model.add(Conv1D(filters=64, kernel_size=3, activation='relu', input_shape=(X_train.shape[1], 1)))

model.add(MaxPooling1D(pool_size=2))

model.add(Conv1D(filters=128, kernel_size=3, activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(Flatten())

model.add(Dense(256, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='linear'))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 模型练习

model.fit(X_train.reshape(X_train.shape[0], X_train.shape[1], 1), y_train, epochs=20, batch_size=64, validation_data=(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test))

# 模型评价

mse = model.evaluate(X_test.reshape(X_test.shape[0], X_test.shape[1], 1), y_test)

print(f'Mean Squared Error on Test Data: {mse}')

# 实时猜测

new_data = np.array([[200, 0.8, 0.3]]) # 请替换为实践的新数据

new_data_scaled = scaler.transform(new_data)

predicted_congestion_level = model.predict(new_data_scaled.reshape(1, new_data_scaled.shape[1], 1))

print(f'Predicted Congestion Level for New Data: {predicted_congestion_level[0][0]}')

这个比如中,咱们增加了更多的卷积层和全衔接层,一起引入了Dropout层以削减过拟合的危险。

模型优化与未来展望

在交通拥堵猜测范畴,模型的优化是一个不断进行的过程。以下是一些模型优化的或许方向和未来展望:

1. 特征工程的进一步优化

在当时示例中,咱们仅运用了车辆流量、路途情况和气候等简略特征。未来,能够考虑引入更多的时空特征,如时刻、日期、节假日等,以更全面地反映交通拥堵的影响要素。

2. 模型结构的改善

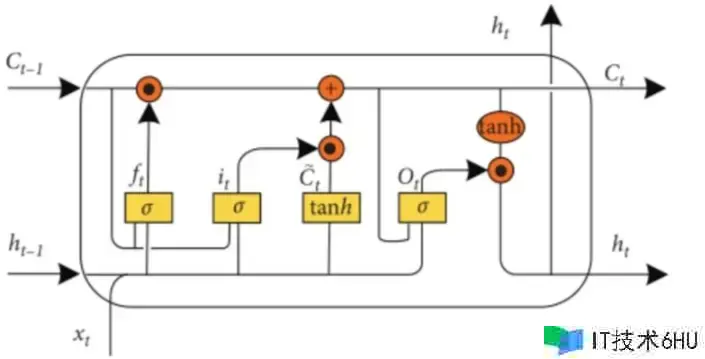

运用更杂乱的神经网络结构,例如循环神经网络(RNN)或长短时记忆网络(LSTM),以更好地捕捉时刻序列数据中的长期依赖关系。此外,选用更深层次的模型结构或者运用预练习模型进行迁移学习也是一种或许的优化手法。

3. 超参数调整

进一步调整模型的超参数,包含学习率、批量大小等,以优化模型的收敛速度和功能。能够运用交叉验证等技能来协助确定最佳的超参数组合。

4. 集成学习办法

测验集成学习办法,如随机森林、梯度提升树等,将多个模型的猜测成果结合起来,以进步整体功能和稳健性。

5. 实时数据更新与在线学习

实时交通数据的不断更新关于模型的猜测效果至关重要。能够考虑完成在线学习(Online Learning)的办法,使模型能够在新数据抵达时进行动态更新,习惯交通情况的实践变化。

6. 布置与集成

将优化后的模型布置到实践交通管理体系中,完成实时拥堵猜测与智能交通控制的集成。此外,与其他城市管理体系(如气候体系、事件管理体系等)进行联动,进步模型的大局功能。

7. 用户反应与改善

搜集用户反应,不断改善模型,以进步其在实践运用中的准确性和实用性。

综合而言,根据卷积神经网络的交通拥堵猜测是一个充溢应战但也充溢希望的范畴。经过不断优化模型和整合多方面的信息,咱们能够期待更加智能、高效的城市交通管理体系的完成,从而改善居民生活质量,进步城市的可继续性。

总结

交通拥堵是城市面临的严峻应战之一,而人工智能技能的运用为处理这一问题供给了创新的途径。本文介绍了根据卷积神经网络(CNN)的交通拥堵猜测办法,并供给了相应的代码实例,从数据搜集、预处理、模型构建到实时猜测等方面进行了全面评论。

首先,经过搜集城市交通数据,包含车辆流量、路途情况、气候等信息,建立了一个示例数据集。然后,运用卷积神经网络对前史交通数据进行学习,构建了一个用于交通拥堵猜测的深层神经网络模型。代码示例涵盖了数据预处理、模型构建、练习、评价以及实时猜测等要害过程。

在模型的优化方面,文章提出了一系列或许的方向,包含特征工程、模型结构改善、超参数调整、集成学习、实时数据更新与在线学习、布置与集成以及用户反应与改善。这些优化战略旨在进步模型的准确性、鲁棒性和实用性,以更好地应对杂乱的城市交通环境。

终究,经过不断优化的交通拥堵猜测模型,咱们有望完成智能交通管理体系的布置,进步城市交通的功率、流畅度,为居民供给更好的出行体会。跟着技能的不断进步和对实时数据的充分运用,交通管理将迎来更为智能、可继续的未来。经过人工智能的运用,咱们能够共同建造更宜居、更智能的城市。