今天,谷歌宣告推出 Gemini 1.5。

Gemini 1.5 建立在谷歌根底模型开发和根底设施的研讨与工程立异的根底上,包括经过新的专家混合 (MoE) 架构使 Gemini 1.5 的练习和服务愈加高效。

谷歌现在推出的是用于前期测验的 Gemini 1.5 的第一个版别 ——Gemini 1.5 Pro。它是一种中型多模态模型,针对多种使命的扩展进行了优化,其功能水平与谷歌迄今为止最大的模型 1.0 Ultra 相似,并引进了长上下文了解方面的突破性试验特征。

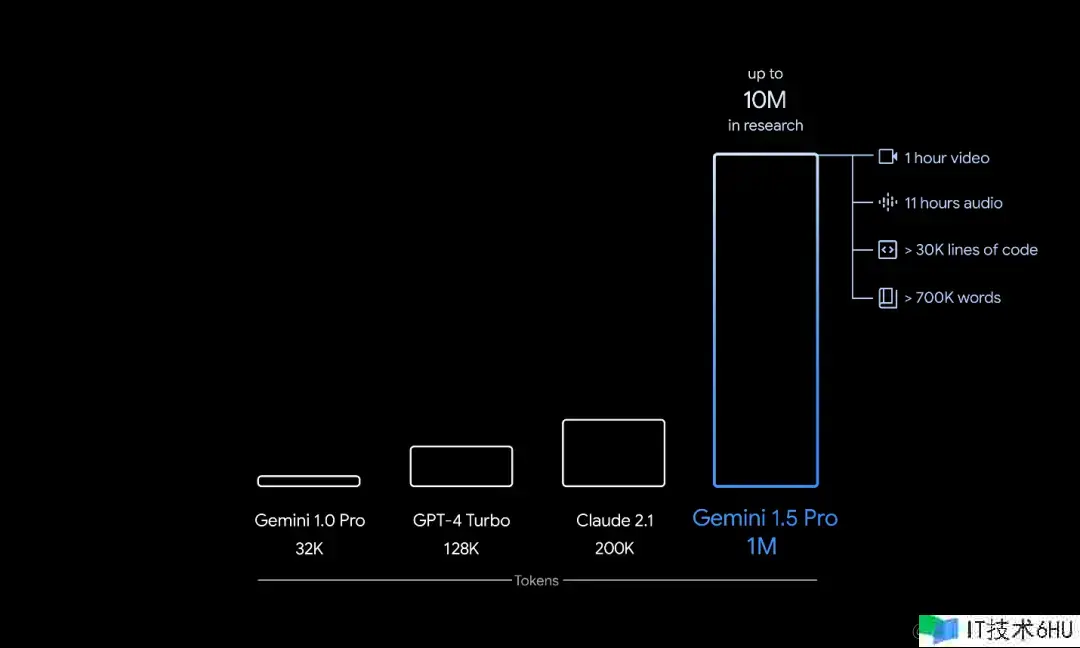

Gemini 1.5 Pro 配备了 128000 个 token 上下文窗口。但从今天开端,少量开发人员和企业客户能够经过 AI Studio 和 Vertex AI 的私人预览版在最多 100 万个 token 的上下文窗口中进行测验。谷歌还进行了一些优化,以改善推迟、减少核算要求并增强用户体会。

谷歌 CEO Sundar Pichai 和谷歌 DeepMind CEO Demis Hassabis 对新模型进行了专门介绍。

抢先根底模型的上下文长度

高效架构

Gemini 1.5 建立在谷歌对 Transformer 和 MoE 架构的抢先研讨之上。传统 Transformer 充当一个大型神经网络,而 MoE 模型则分为更小的 “专家” 神经网络。

根据给定输入的类型,MoE 模型学会选择性地仅激活其神经网络中最相关的专家路径。这种专业化极大地进步了模型的功率。经过稀疏门控 MoE、GShard-Transformer、Switch-Transformer、M4 等研讨,Google 一直是深度学习 MoE 技能的前期采用者和前驱。

谷歌在模型架构方面的最新立异使 Gemini 1.5 能够更快地学习复杂使命并坚持质量,一起更高效地练习和服务。这些功率正在协助谷歌团队比以往更快地迭代、训练和交付更高档的 Gemini 版别,并且正在努力进一步优化。

更长的上下文,更有用的功能

人工智能模型的 “上下文窗口” 由 token 组成,token 是用于处理信息的构建块。token 能够是文字、图画、视频、音频或代码的整个部分或子部分。模型的上下文窗口越大,它在给定提示中能够接纳和处理的信息就越多,从而使其输出愈加一致、相关和有用。

经过一系列机器学习立异,谷歌增加了 1.5 Pro 的上下文窗口容量,远远超出了 Gemini 1.0 最初的 32,000 个 token。该大模型现在能够在出产环境中运转多达 100 万个 token。

这意味着 1.5 Pro 能够一次性处理很多信息,包括 1 小时的视频、11 小时的音频、超越 30,000 行代码或超越 700,000 个单词的代码库。在谷歌的研讨中,还成功测验了多达 1000 万个 token。

对很多信息进行复杂推理

1.5 Pro 能够在给定提示内无缝分析、分类和总结很多内容。例如,当给出阿波罗 11 号登月使命的 402 页记录时,它能够推理整个文档中的对话、事件和细节。

Gemini 1.5 Pro 能够了解、推理和辨认阿波罗 11 号登月使命的 402 页记录中的好奇细节。

更好地了解和推理跨模态

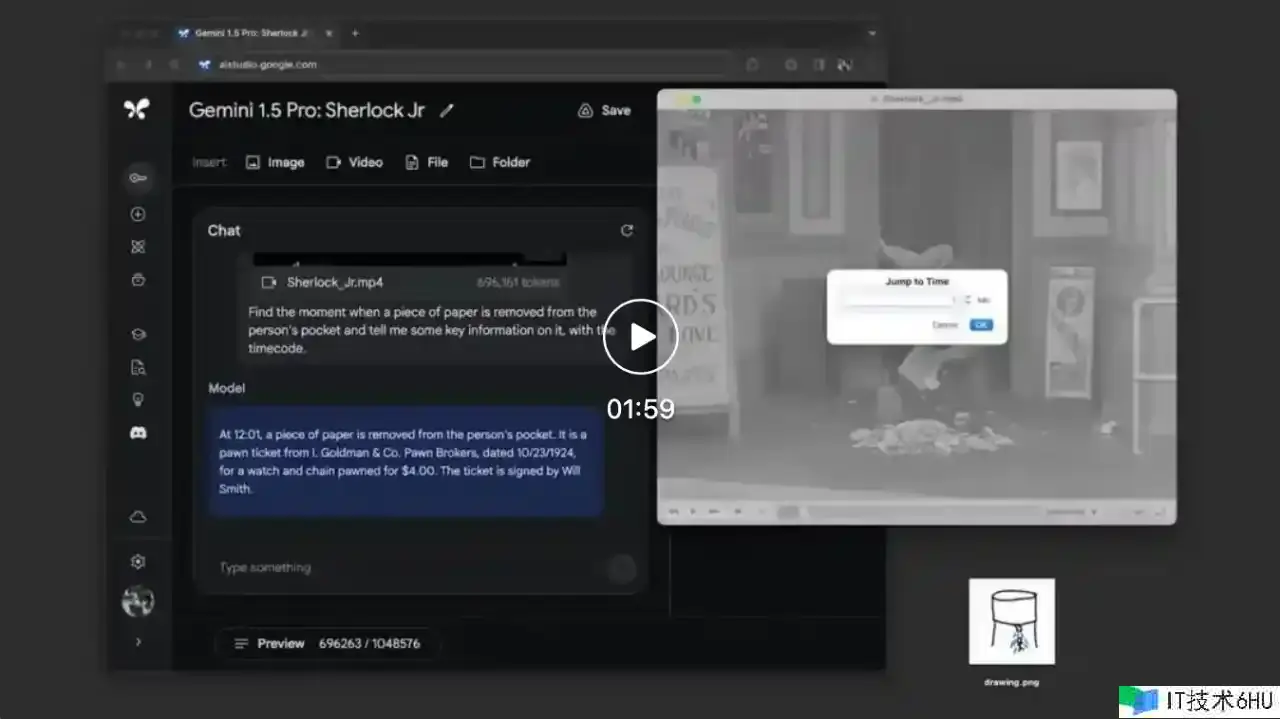

1.5 Pro 能够针对包括视频在内的不同形式执行高度复杂的了解和推理使命。例如,当给定一部 44 分钟的巴斯特・基顿无声电影时,该模型能够精确分析各种情节点和事件,甚至推理出电影中容易被疏忽的小细节。

当给出简略的线条图作为现实生活中物体的参阅资料时,Gemini 1.5 Pro 能够辨认 44 分钟的巴斯特基顿无声电影中的场景。

运用较长的代码块解决相关问题

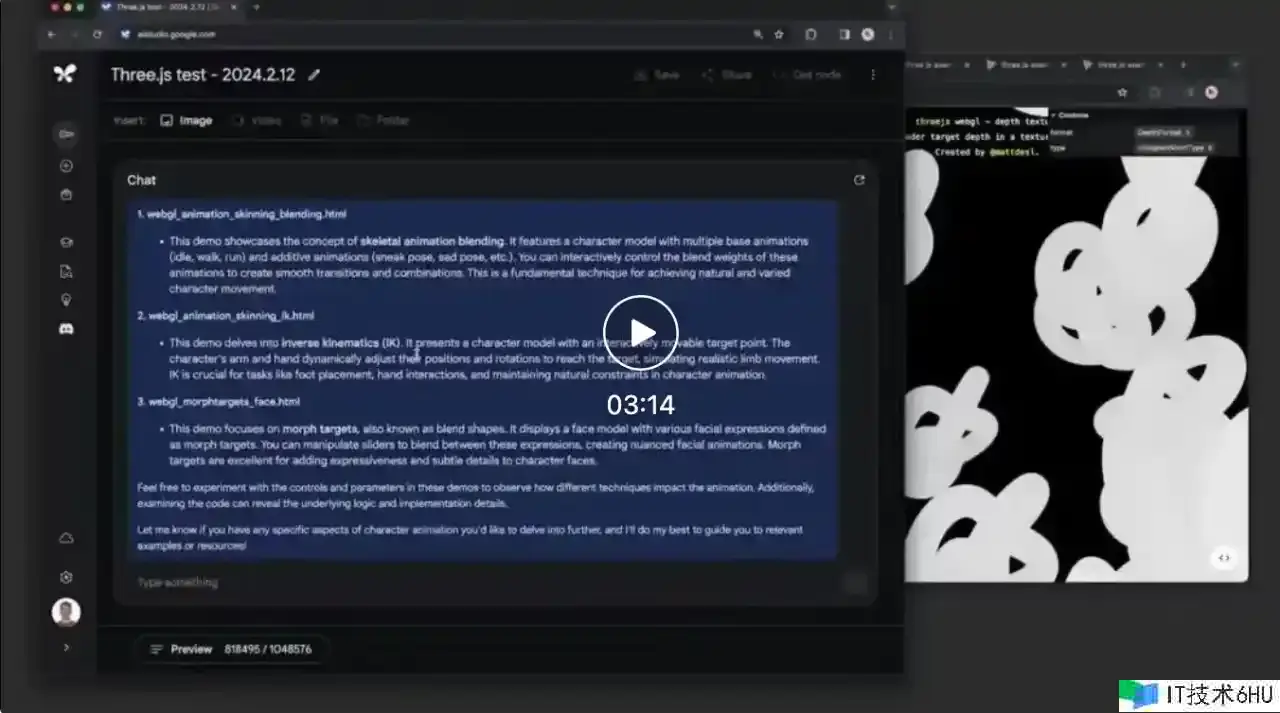

1.5 Pro 能够跨较长的代码块执行更相关的问题解决使命。当给出超越 100,000 行代码的提示时,它能够更好地推理示例、主张有用的修正并解说代码不同部分的作业原理。

Gemini 1.5 Pro 能够推理 100,000 行代码,供给有用的解决方案、修正和注释

增强功能

在文本、代码、图画、音频、视频评价综合面板上进行测验时,1.5 Pro 在用于开发大型言语模型 (LLM) 的基准测验中,87% 的功能优于 1.0 Pro。在相同的基准测验中与 1.0 Ultra 比较,它的体现大致相似。

即使上下文窗口增加,Gemini 1.5 Pro 仍能坚持高水平的功能。

在 NIAH 评价中,成心将包括特定现实或陈说的一小段文本放置在很长的文本块中,1.5 Pro 99% 的时间都能找到嵌入的文本,在数据块中如下只要 100 万个 token。

Gemini 1.5 Pro 还展现了令人印象深入的 “上下文学习(in-context learning)” 技能,这意味着它能够从长提示中给出的信息中学习新技能,而不需要额外的微调。谷歌在 MTOB (Translation from One Book )基准测验中测验了这项技能,该基准显示了该模型从曾经从未见过的信息中学习的才能。当给定卡拉芒语(一种全球运用人数缺乏 200 人的言语)的语法手册时,该模型能够学习将英语翻译成卡拉芒语,其水平与学习相同内容的人相似。

因为 1.5 Pro 的长上下文窗口是大型模型中的创始,因此谷歌正在不断开发新的评价和基准来测验其新颖的功能。

有关更多详细信息,请参阅 Gemini 1.5 Pro 技能陈述。

技能陈述地址:storage.googleapis.com/deepmind-me…

运用 Gemini 模型进行构建和试验

谷歌致力于负责任地将每个新一代 Gemini 模型带给全球数十亿人、开发者和企业用户运用。

从今天开端,谷歌将经过 AI Studio 和 Vertex AI 向开发者和企业客户供给 1.5 Pro 预览版。

未来,当模型进行更广泛的发布时,到时,谷歌将推出具有规范 128,000 个 token 上下文窗口的 1.5 Pro。很快,跟着谷歌对模型的改善,谷歌方案引进从规范 128,000 个上下文窗口开端并扩展到 100 万个 token 的定价等级。

前期测验人员能够在测验期间免费测验 100 万个 token 上下文窗口,速度的显着进步也即将到来。

有兴趣测验 1.5 Pro 的开发人员现在能够在 AI Studio 中注册,而企业客户能够联系他们的 Vertex AI 客户团队。