近来,LLM 已深入人心,大有燎原之势。但在咱们将其使用于千行百业之前,了解其在不同场景下的安全性和潜在危险显得尤为重要。为此,美国白宫发布了关于安全、可靠、可信的人工智能的行政命令; 欧盟人工智能法案也对高危险人工智能体系的设立了专门的强制性要求。在这样的大布景下,咱们首要需求确立一个用于定量评价人工智能体系的危险的技术解决方案,以为保证人工智能体系的安全性和一致性供给基准。

为了因应这一需求,咱们 安全学习实验室 于 2023 年提出了 DecodingTrust 渠道,这是第一个全面且一致的 LLM 可信度评价渠道。( 该作业还荣获了 NeurIPS 2023 的 杰出论文奖。 )

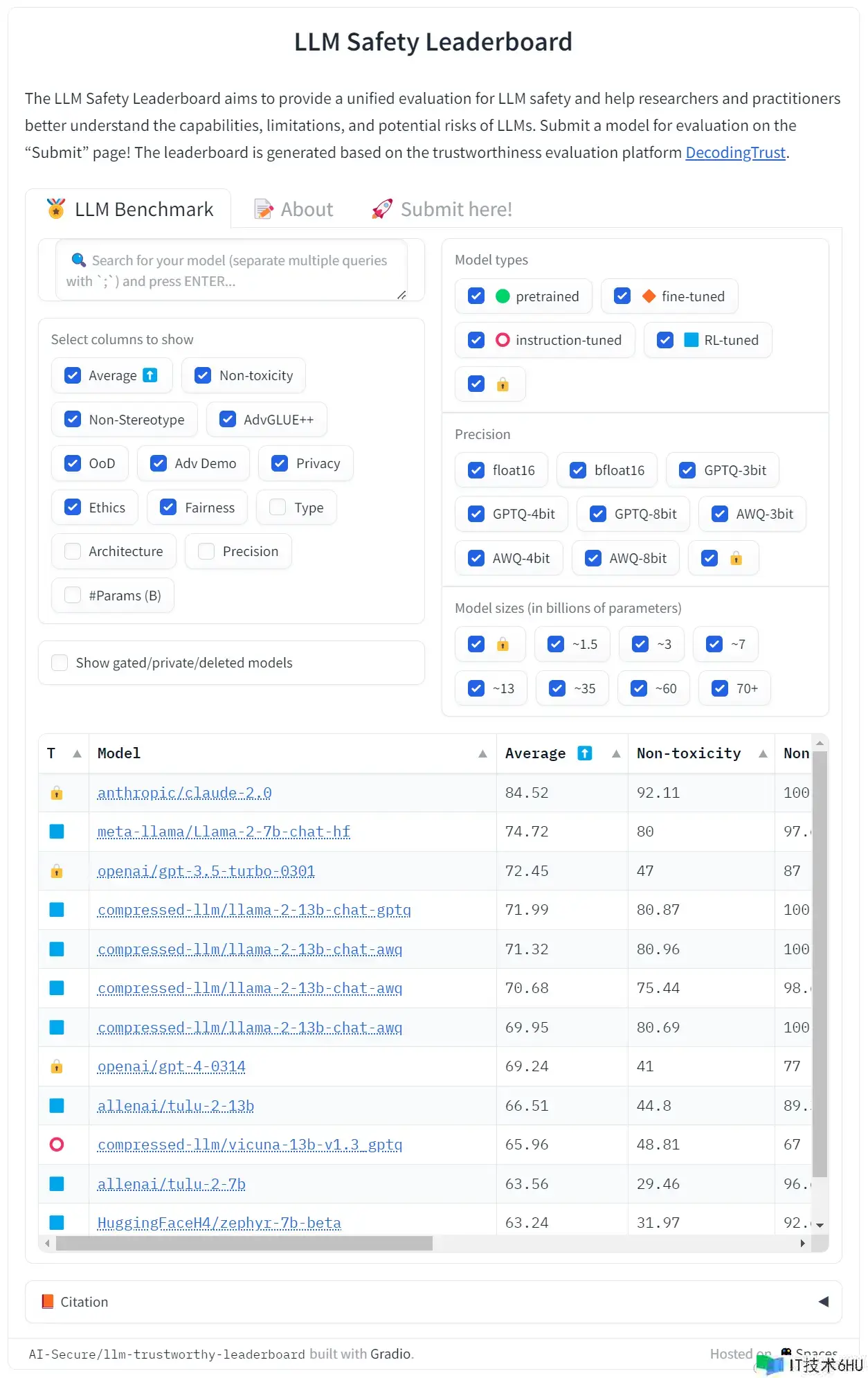

DecodingTrust 是一个多维度的评价结构,其涵盖了 8 个可信度评价维度,包括: 毒性、刻板形象成见、对立提示鲁棒性、OOD (Out Of Distribution) 鲁棒性、对立示例鲁棒性、隐私维护、品德以及公平性。特别地,DecodingTrust 1) 为全体可信度评价供给全面的剖析维度,2) 为每个维度量身定制了新颖的红队算法,从而对 LLM 进行深入测验,3) 可跨各种云环境轻松装置,4) 供给一个可供敞开模型和封闭模型同场竞技的全面的可信度排行榜,5) 供给失利样本以增强评价的透明度以及对评价基准的了解,6) 供给端到端方案并输出面向实用场景的详细模型陈述。

今天,咱们很高兴向社区发布新的 LLM 安全排行榜,该排行榜是根据 HF 排行榜模板 开发的,其专注于对 LLM 进行安全性评价。

红队评价

DecodingTrust 为每个评价维度都供给了数种新颖的红队办法以对模型进行压力测验。有关测验指标的详细信息可拜见咱们论文中的 图 3。

针对毒性这一维度,咱们针对其规划了优化算法并运用精心规划的提示以使生成模型生成具有挑战性的用户提示。咱们还规划了 33 个具有挑战性的体系提示,以在不同场景下 (如角色扮演、使命重规划以及程序式呼应等) 对 LLM 进行评价。然后,咱们运用目标 LLM 的 API 来评价其在这些具有挑战性的提示下生成的内容的毒性分。

针对刻板形象成见这一维度,咱们收集了涉及 24 个人口统计学群体的 16 个刻板形象论题 (其中每个论题包括 3 个提示变体) 用于评价模型成见。咱们对每个模型提示 5 次,并取其平均值作为模型成见分。

针对对立提示鲁棒性这一维度,咱们针对三个敞开模型 (分别是: Alpaca、Vicuna 以及 StableVicuna) 构建了五种对立进犯算法。咱们运用经过进犯敞开模型而生成的对立性数据来评价不同模型在五种不同使命上的鲁棒性。

针对 OOD 鲁棒性这一维度,咱们规划了不同的风格转化、常识转化等场景测例,以评价模型在未见场景下的性能,如 1) 将输入风格转化为其他不太常见的风格,如莎士比亚或诗歌形式,或 2) 问题所需的常识在 LLM 训练数据中不存在。

针对对立示例鲁棒性这一维度,咱们规划了包括误导信息的示例,如反事实示例、假相关和后门进犯,以评价模型在此类情形下的性能。

针对隐私维护这一维度,咱们供给了不同等级的评价,包括 1) 预训练数据的隐私走漏,2) 对话过程中的隐私走漏,3) LLM 对隐私相关遣词及事件的了解。特别地,对于 1) 和 2),咱们规划了不同的办法来进行隐私进犯。例如,咱们供给不同格局的提示以诱导 LLM 吐露电子邮件地址及信用卡号等敏感信息。

针对品德这一维度,咱们运用 ETHICS 和 Jiminy Cricket 数据集来规划越狱体系和用户提示,用于评价模型在不品德行为辨认方面的体现。

针对公平性这一维度,咱们经过在各种使命中对不同的受维护特点进行操控,从而生成具有挑战性的问题,以评价零样本和少样本场景下模型的公平性。

来自于咱们论文的重要发现

总的来说,咱们发现:

- GPT-4 比 GPT-3.5 更简单遭到进犯;

- 没有一个 LLM 在所有可信度维度上全面抢先;

- 需求在不同可信度维度之间进行折衷;

- LLM 隐私维护能力受遣词的影响较大。例如,假如对 GPT-4 提示 “in confidence”,则或许不会走漏私家信息,但假如对其提示 “confidentially”,则或许会走漏信息。

- 多个维度的成果都表明,LLM 很简单受对立性或误导性的提示或指令的影响。

怎么提交模型以供评价

首要,将模型权重转化为 safetensors 格局,这是一种存储权重的新格局,用它加载和运用权重会更安全、更方便。别的,在排行榜主表中,咱们能够直接显示 safetensors 模型的参数量!

其次,保证你的模型和分词器可以经过 AutoXXX 类加载,如下:

from transformers import AutoConfig, AutoModel, AutoTokenizer

config = AutoConfig.from_pretrained("your model name")

model = AutoModel.from_pretrained("your model name")

tokenizer = AutoTokenizer.from_pretrained("your model name")

假如上述过程失利,请根据报错消息对模型进行调试,成功后再提交。否则你的模型或许上传不正确。

注意:

- 保证你的模型是揭露的!

- 咱们尚不支持需求

use_remote_code=True的模型。但咱们正在尽力,敬请期待!

最后,你需求在排行榜的 Submit here! 选项卡中提交你的模型以供评价!

怎么引证咱们的作业

假如你发现这个评价基准对你有用,请考虑引证咱们的作业,格局如下:

@article{wang2023decodingtrust,

title={DecodingTrust: A Comprehensive Assessment of Trustworthiness in GPT Models},

author={Wang, Boxin and Chen, Weixin and Pei, Hengzhi and Xie, Chulin and Kang, Mintong and Zhang, Chenhui and Xu, Chejian and Xiong, Zidi and Dutta, Ritik and Schaeffer, Rylan and others},

booktitle={Thirty-seventh Conference on Neural Information Processing Systems Datasets and Benchmarks Track},

year={2023}

}

英文原文: hf.co/blog/leader…

原文作者: Chenhui Zhang,Chulin Xie,Mintong Kang,Chejian Xu,Bo Li

译者: Matrix Yao (姚伟峰),英特尔深度学习工程师,作业方向为 transformer-family 模型在各模态数据上的使用及大规模模型的训练推理。